TSUBAME3.0は東京工業大学学術国際情報センター(GSIC)が運用管理するスーパーコンピュータです。正式名称は「クラウド型ビッグデータグリーンスーパーコンピュータ」となります。TSUBAME3.0 は半精度以上で 47.2PFlops の理論演算性能を持ち,従来型 HPC に加えてビッグデータ・ AI など幅広いワークロードを処理する日本最大級のスパコンとなる見込みです。また、高密度化と省電 力化を追求し理論 PUE 値 1.033 を実現します。

⚠️⚠️⚠️運用終了したTSUBAME3のページです⚠️⚠️⚠️

TSUBAME4.0のWebサイトはこちら

一般

TSUBAMEポイント・TSUBAMEポータル

ジョブの実行(スケジューラ)

アプリケーション

Tips (便利な設定など)

一般

注意: SSH秘密鍵が漏洩すると他人にアカウントを不正利用されることとなりますので、パスフレーズを必ず設定し、管理には細心の注意を払ってください。

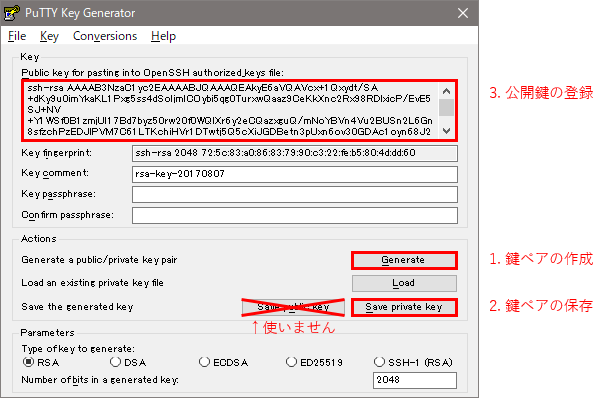

PuTTY付属のPuTTYgenを用いてTSUBAMEにログインするための鍵ペアを作成する方法について説明します。

MobaXtermのMobaKeyGenも同等の機能・UIを持つため、同様に利用できます。PuTTYgenを起動すると下記のような画面が出てきます(日本語で表示される場合もあります)

- 「Generate」ボタンを押して、画面の指示に従って鍵ペアを作成します

最下段のParametersを変更することで生成される鍵ペアの設定を変えることができますが、通常は変更する必要はありません - 「Save private key」ボタンを押すことで、この鍵ペアを使用するために必要なファイル(秘密鍵)を保存することができます。

TSUBAME3に公開鍵を登録することで、保存した秘密鍵ファイルにアクセスできるすべての人がTSUBAME3にログインできるようになりますので、ファイルの管理は十分に注意してください。(USBメモリに入れて持ち歩いたり、メールで送信しないこと)

保存前に「Key passphrase」「Confirm passphrase」にパスフレーズを入力することで、パスフレーズを知らない人が鍵を利用する(TSUBAME3を利用する)ことを防ぐことができます。 - 「Public key for pasting...」の中に表示されている文字列を、TSUBAMEポータルの「SSH公開鍵登録」画面の「公開鍵コード入力」テキストボックスにコピー&ペーストして、「追加」ボタンを押すことで、公開鍵がTSUBAMEに登録されます。

TSUBAMEにログインする際には、事前に2.で保存したファイルをPageantで開いておく(インストーラを利用してPuTTYをデフォルト設定でインストールした場合、ファイルの関連付けがされています)か、PuTTYの接続設定で「Connection」-「SSH」-「Auth」の中にある「Private key file for authentication」で指定しておくことで、作成した鍵ペアを利用してログインすることができます。

*ParametersのSSH-1(RSA)は絶対に選ばないで下さい。

なお、PuTTYの利用方法についてはご自分でマニュアルをご確認下さい。

- 「Generate」ボタンを押して、画面の指示に従って鍵ペアを作成します

GNU、Intel CompilerとOpenMPIの組み合わせで利用が可能です。

OpenMPIのmoduleをloadする前に使用するコンパイラのmoduleをloadすることによりご利用可能です。

GNUについてはOS提供のものとなりますので、4.8.5となります。

利用可能なバージョンについては以下のコマンドで確認してください。$ module av

以下、ご利用方法になります。1. Intel版OpenMPI

$ module load intel

$ module load cuda

$ module load openmpi/2.1.1

$ mpicc -V

Intel(R) C Intel(R) 64 Compiler for applications running on Intel(R) 64, Version 17.0.4.196 Build 20170411 Copyright (C) 1985-2017 Intel Corporation. All rights reserved.2. GNU版OpenMPI

$ module purge /*既にload されているmoduleのpurge*/

$ module load cuda $ module load openmpi/2.1.1

$ mpicc -v

Using built-in specs. COLLECT_GCC=/usr/bin/gcc COLLECT_LTO_WRAPPER=/usr/lib64/gcc/x86_64-suse-linux/4.8/lto-wrapper Target: x86_64-suse-linux Configured with: ../configure --prefix=/usr --infodir=/usr/share/info --mandir=/usr/share/man --libdir=/usr/lib64 --libexecdir=/usr/lib64 --enable-languages=c,c++,objc,fortran,obj-c++,java,ada --enable-checking=release --with-gxx-include-dir=/usr/include/c++/4.8 --enable-ssp --disable-libssp --disable-plugin --

TSUBAMEの利用は教育・研究・事務・社会貢献目的に限ります。私的な金銭的利益に直結するような用途に利用することはできません。

既定の端末設定では特定の入力文字によるフロー制御が有効になっていることが原因です。

フロー制御とは、データ転送において受信パケット速度よりも送信速度が上回る場合などに、受信側のオーバーフローを防ぐために転送を一時保留にする機能です。一般的には、転送の保留には Ctrl+S 、再開には Ctrl+Q が制御文字として使用されます。インタラクティブ実行中にEmacsで編集し上書き保存する場合にCtrl+Sを入力しなければなりませんが、これはフロー制御文字でもあるためパケットが転送されなくなり、あたかもフリーズしてしまったかのような状態となります。元に戻すには、Ctrl+Q を入力してください。

フロー制御を無効にするにはインタラクティブジョブ実行前に以下のコマンドを実行する必要があります。

stty -ixon

フロー制御を常に無効にしたい場合は、ホームディレクトリの .bashrc に上記コマンドを追記してください。

Module fileの基本構成について記載します。

- [アプリケーション名]/[バージョン] となっています。

- module コマンドでバージョンまで指定しなくともデフォルトでloadされる版が設定されています。

複数のバージョンが存在しデフォルトが設定されている場合には、バージョンの後に"(default)"と表示されています。

例)

$ module load intel

$ module listCurrently Loaded Modulefiles:

1) intel/17.0.4.196

- MPIやアプリケーションなど依存関係があるものについては、事前に load することで利用可能になります。

例)namd

必要なmoduleなどはエラー表示されます。

$ module load namd

namd/2.12(3):ERROR:151: Module 'namd/2.12' depends on one of the module(s) 'intel/17.0.4.196 intel/16.0.4.258'

namd/2.12(3):ERROR:102: Tcl command execution failed: prereq intelIntel Compilerとcudaをload後、namdをloadします。

$ module load intel

$ module load cuda

$ module load namd

$ module listCurrently Loaded Modulefiles:

1) intel/17.0.4.196 2) cuda/8.0.44 3) namd/2.12

UGEではf_nodeを除き、指定した資源数に応じた仮想的なCPUID/GPUIDを割り当てます。

- CPUの場合

CPUを1つのみ確保する資源タイプのs_coreとCPU4つ確保する資源タイプq_coreを例にあげますと、

s_core=7と指定を行った際は、ノードが7つ確保され、各ノードの1coreが割り当てられます。

q_core=7と指定を行った際は、ノードが7つ確保され、各ノードの4coreが割り当てられます。- GPUの場合

GPUを1つのみ確保する資源タイプのs_gpuの場合は、

s_gpu=4と指定を行った際は、ノードが4つ確保され、各ノードのGPUが仮想的にGPU0として割り当てられます。

4つ確保したからといってGPU0,1,2,3ということにはなりません。GPUを2つ確保する資源タイプであるh_nodeではノード内でGPUが2割り当てられますが、この場合はGPU0,1が割り当てられます。

ログインノードと計算ノードの相違点は以下の通りです。

1. ハードウェア

ログインノード 計算ノード ノード数 2 540 CPU Intel Xeon E5-2637 v4 3.50GHz 16core x 2

Intel Xeon E5-2680 v4 2.40GHz 14core x 2

Memory 64GiB 256GiB GPU - NVIDIA Tesla P100 x4 Interconnect Intel Omni-Path HFI 100Gbps x2 Intel Omni-Path HFI 100Gbps x4 NVMe SSD - Intel SSD DC P3500 2TB 2. ソフトウェア

ログインノード 計算ノード OS SUSE Linux Enterprise 12 SP2 SUSE Linux Enterprise 12 SP2 kernel 4.4.74-92.29-default

4.4.74-92.29-default

GPU Driver

-

nvidia-375.66

ログインノードは、共有サーバであるため、プログラム実行などの作業は行わないようお願いします。

実行してしまった場合は至急killコマンドを実行し、プログラムを停止して下さい。

注意: SSH秘密鍵が漏洩すると他人にアカウントを不正利用されることとなりますので、パスフレーズを必ず設定し、管理には細心の注意を払ってください。

Linux/Mac/Windows(CygwinもしくはOpenSSH)でのSSH鍵ペア作成方法は以下のとおりです。

鍵の形式の違いについてはman ssh-keygenコマンドで確認してください。

インストールされているopensshのバージョンによって対応/未対応があります。ecdsa鍵形式

$ ssh-keygen -t ecdsa RSA鍵形式

$ ssh-keygen -t rsa ed25519鍵形式

$ ssh-keygen -t ed25519 上記いずれかのコマンドを実行すると保存場所の指定を聞かれます。

既に同名の鍵ファイルを使用中などの事情がなければ、そのままEnterキーを押してください。

(他のサイト向けに作成したSSH鍵ペアをTSUBAMEで再利用することは問題ありません)Generating public/private 実行したコマンドの鍵形式 key pair.

Enter file in which to save the key ユーザディレクトリ/.ssh/id_実行したコマンドの鍵形式: (何も入れずに)[Enter]次にパスフレーズが聞かれますので、入力します。

Enter passphrase (empty for no passphrase): (設定するパスフレーズを入力・画面には表示されません) [Enter] パスフレーズの確認が入りますので、入力します。

Enter same passphrase again: (上で設定したパスフレーズを再度入力・画面には表示されません) [Enter] SSH鍵ペアが出力されます。上が秘密鍵、下が公開鍵です。TSUBAMEには公開鍵を登録ください。

our identification has been saved in ユーザディレクトリ/.ssh/id_実行したコマンドの鍵形式

Your public key has been saved in ユーザディレクトリ/.ssh/id_実行したコマンドの鍵形式 .pub.

The key fingerprint is:

SHA256:乱数:ユーザ@ホスト名

The key's randomart image is:

(鍵ペアに固有の情報が出力されます)下記コマンドでファイルを確認します。

$ ls ~/.ssh/ -l

drwx------ 2 ユーザ グループ 512 Oct 6 10:50 .

drwx------ 31 ユーザ グループ 4096 Oct 6 10:41 ..

-rw------- 1 ユーザ グループ 411 Oct 6 10:50 秘密鍵

-rw-r--r-- 1 ユーザ グループ 97 Oct 6 10:50 公開鍵パーミッションがあってない場合は以下のコマンドで修正します。

$ chmod 700 ~/.ssh

$ chmod 600 ~/.ssh/秘密鍵

問い合わせの前に下記の点を御確認ください。

1.アカウントが正しいかどうか

TSUBAME3のアカウントであるかをご確認ください。

TSUBAME2のアカウントを利用したお問合わせが増えております。

アカウントの取得については下記を参照ください。

http://www.t3.gsic.titech.ac.jp/getting-account

2.鍵ペアが正しいかどうか

TSUBAMEポータルに登録した公開鍵がopenssh形式であるかをご確認ください。

PuTTY形式の公開鍵を登録してもTSUBAMEにはアクセスできません。鍵ペアの作成については下記を参照ください。

http://www.t3.gsic.titech.ac.jp/node/37

http://www.t3.gsic.titech.ac.jp/node/79公開鍵の登録については下記を参照ください。

https://helpdesk.t3.gsic.titech.ac.jp/manuals/portal.ja/prepare/#ssh_key

3.コマンドが正しいかどうかLinux/Mac/Windows(Cygwin)

SSHコマンドのオプション等で指定しているログイン名や秘密鍵のパス(※)が正しいかをご確認ください。$ ssh TSUBAME3アカウント名@login.t3.gsic.titech.ac.jp -i 秘密鍵

例) ログイン名がgsic_user、秘密鍵がホームディレクトリの .ssh/t3-key の場合

$ ssh gsic_user@login.t3.gsic.titech.ac.jp -i ~/.ssh/t3-key

※: 秘密鍵がホームディレクトリ内 .ssh/id_rsa, .ssh/id_dsa, .ssh/id_ecdsa, .ssh/id_ed25519 のいずれかの場合 (ssh-keygenで保存場所をデフォルトから変更しなかった場合)、「-i 秘密鍵」を指定する必要がありません

SSHのオプションについては下記のコマンドで確認してください。

$ man ssh

4.端末環境を変えても再現するか

Windowsの場合はフリーの端末ソフトウェアが多くございます。

別の端末ソフトウェアでも再現するかどうかをご確認ください。

再現しない場合はソフトウェア固有の問題である可能性がございます。

その場合はお問合わせ頂いてもご対応できかねますので、ご了承ください。

お問い合わせの際は下記をご連絡ください

■利用OS(例 Windows10,Debian10,macOS Sierra10.12.6)■利用端末ソフトウェア(windowsのみ、例 Cygwin,PuTTY,Rlogin)

■利用端末バージョン

windowsの場合は端末ソフトウェアのバージョン、例 2.9.0-3,0.70,2.22.7

バージョンの調べ方はご利用の端末のマニュアルをご確認ください。

Linux/Macの場合はSSHのバージョンをお送りください。下記のコマンドで確認できます。$ ssh -V

■今まで試した内容について、また、エラーが出る場合はエラーの内容をお送りください。

Linux/Macの場合は-vオプションを利用し、コマンドラインを含めた詳細なログも出力ください。

例)アカウント名がgsic_user、秘密鍵が~/.ssh/t3-keyの場合の例$ ssh gsic_user@login.t3.gsic.titech.ac.jp -i ~/.ssh/t3-key -v

ログインノード等のプログラム実行を禁止しているノードで、

プログラムを実行してしまった場合は以下の手順でプログラムを停止して下さい。

バッチジョブスケジューラに投入したジョブについては

FAQ「バッチジョブスケジューラに投入したジョブの停止方法について」をご確認下さい。1.実行したプロセスの確認

top、psコマンドなどでプロセスを確認します。

GSICユーザがpythonを並列実行した場合を例とします。

topコマンドなどでプロセスを確認します。$ top

Tasks: 1457 total, 1 running, 1441 sleeping, 11 stopped, 3 zombie

%Cpu(s): 78.8 us, 1.3 sy, 0.0 ni, 96.8 id, 0.0 wa, 0.0 hi, 0.1 si, 0.0 st

KiB Mem: 65598488 total, 18563160 used, 47035328 free, 8 buffers

KiB Swap: 7812092 total, 7422860 used, 389232 free. 6553100 cached Mem

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

20680 GSIC 20 0 1157756 5.056g 20628 R 1467.0 1.688 0:01.88 python

1 root 20 0 479464 294444 2940 S 0.000 0.449 76:02.24 systemd

2 root 20 0 0 0 0 S 0.000 0.000 11:25.50 kthreadd

3 root 20 0 0 0 0 S 0.000 0.000 9:48.70 ksoftirqd/0

9 root 20 0 0 0 0 S 0.000 0.000 0:00.00 rcu_bh

10 root rt 0 0 0 0 S 0.000 0.000 0:45.45 migration/02.確認したプロセスの停止

実際は確認したPIDに合わせて実行して下さい。

例では1で確認したPID20680を停止します。$ kill 20680

3.プロセスの停止が出来たかの確認

top、psコマンドなどでプロセスが停止したかを確認します。

下記の例では停止していないため4に進みます。

表示されない場合は念のため、psコマンドを打ち、プロセスが表示されないかを確認して下さい。$ top

Tasks: 1457 total, 1 running, 1441 sleeping, 11 stopped, 3 zombie

%Cpu(s): 78.8 us, 1.3 sy, 0.0 ni, 96.8 id, 0.0 wa, 0.0 hi, 0.1 si, 0.0 st

KiB Mem: 65598488 total, 18563160 used, 47035328 free, 8 buffers

KiB Swap: 7812092 total, 7422860 used, 389232 free. 6553100 cached Mem

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

20680 GSIC 20 0 1157756 5.056g 20628 R 1467.0 1.688 0:05.92 python4.プロセスの強制停止

2,3で停止が確認できない場合は下記のコマンドを実行して下さい。

実行後は3の手順にて確認して下さい。$ kill -9 20680

ここでいう「利用」はプログラムの実行のことを指します。

TSUBAME3を利用するまでに必要な作業としては以下の6つがあります。

ログインだけであれば、2までの作業が完了すればログイン可能です。

利用には5までの作業が必要となります。

利用にあたって、25GiB以上のディレクトリの割り当てが必要な場合は6を行う必要があります。

1.アカウント取得

2.SSH鍵ペアの作成と公開鍵の登録

3.グループの作成[グループ管理者のみ]

4.グループメンバの登録[グループ管理者とグループメンバ]

5.ポイント購入[グループ管理者のみ]

6.グループディスクの設定[グループ管理者のみ]

各手順での詳細な操作については

「TSUBAMEポータル利用の手引き」をご確認下さい。TSUBAME3で提供されるディレクトリについては

「TSUBAME3.0利用の手引き 3. ストレージ環境」をご確認下さい。1,2およびログインについては

FAQの「TSUBAME3にログインが出来ません」に記載があります。それぞれご確認下さい。

TSUBAME3ではrsync、scp、sftpによるファイル転送が可能です。

ログイン同様、TSUBAME3ポータルに登録したSSH公開鍵のペアとなるSSH秘密鍵を用いてアクセスする必要があります。

また、利用されているアプリケーションによってはタイムアウトになる場合もありますので、

ご利用されているアプリケーションの設定をよくご確認下さい。- ファイル転送アプリケーションをインストールする場合 (Windows等)

- Linux/Mac/Cygwin(Windows)を使用している場合 (rsync, scp, sftpコマンド)

- CIFSによるアクセスを行う場合

ファイル転送アプリケーションをインストールする場合

MobaXtermおよびRLoginを利用している場合、これらのソフトウェアにはファイル転送機能が組み込まれているため、そちらを利用するのが簡便です。

PuTTYなどこれら以外のソフトウェアを接続に利用している場合、FileZilla、WinSCPなどの、sftp, rsyncプロトコルに対応したファイル転送用アプリケーションをインストールする必要があります。

この場合でもログイン同様、TSUBAME3ポータルに登録したSSH公開鍵のペアとなるSSH秘密鍵を用いてアクセスする必要があります。

Filezilla、WinSCPではPuTTYで普段使用している.ppk 形式の鍵ファイルがそのまま利用可能です。

各ソフトウェアの利用方法の詳細は各ソフトウェアのマニュアルを各自ご確認下さい。また、Windows 10のオプション機能のOpenSSHクライアントを有効にすることで、コマンドプロンプトやPowerShellから次項のscp, sftpコマンドを使用することもできます。

Linux/Mac/Cygwin(Windows)等を使用している場合

これらの環境では rsync、scp、sftp の各コマンドが利用できます。

以下、それぞれの使い方について説明します。rsyncの場合

ローカルからリモートホストに転送する場合は、以下のようなコマンドを実行して下さい。

鍵ペアの格納場所を標準のパス・ファイル名とした場合には-iオプションは指定不要です。$ rsync -av --progress -e "ssh -i 秘密鍵ファイル -l ログイン名" ローカルディレクトリ リモートホスト:リモートディレクトリ

<ローカルディレクトリ>が転送元、<リモートホスト>:<リモートディレクトリ> が転送先です。

<>の部分は状況に適したものを入力してください。例えば、ログイン名がGSCIUSER00のユーザが秘密鍵の ~/.ssh/ecdsa を用いて、カレントディレクトリをTSUBAME3の/gs/hs0/GSICにコピーする場合のコマンドは以下になります。$ rsync -av --progress -e "ssh -i ~/.ssh/ecdsa -l GSICUSER00" ./ login.t3.gsic.titech.ac.jp:/gs/hs0/GSIC

転送元や転送先の指定の仕方などの使用方法の詳細は以下のコマンドを実行して確認して下さい。

$ man rsync

scpの場合

リモートホストからローカルに転送する場合は、以下のようなコマンドを実行して下さい。

鍵ペアの格納場所を標準のパス・ファイル名とした場合には-iオプションは指定不要です。$ scp -i 秘密鍵ファイル ログイン名@リモートホスト:リモートディレクトリ ローカルディレクトリ

<>の部分は状況に適したものを入力してください。

ログイン名がGSCIUSER00のユーザが秘密鍵の ~/.ssh/ecdsa を用いて、カレントディレクトリにTSUBAME3の/gs/hs0/GSICをコピーする場合の例は下記のコマンドとなります。$ scp -i ~/.ssh/ecdsa GSICUSER00@login.t3.gsic.titech.ac.jp:/gs/hs0/GSIC .

オプションの詳細は以下のコマンドを実行して確認して下さい。

$ man scp

sftpの場合

インタラクティブに転送を行う場合は以下のようなコマンドを実行して下さい。

鍵ペアの格納場所を標準のパス・ファイル名とした場合には-iオプションは指定不要です。$ sftp -i 秘密鍵ファイル ログイン名@リモートホスト

<>の部分は状況に適したものを入力してください。

例えば、ログイン名がGSCIUSER00のユーザが秘密鍵の.ssh/ecdsaを用いて、TSUBAME3にアクセスする場合は下記のコマンドとなります。$ sftp -i ~/.ssh/ecdsa GSICUSER00@login.t3.gsic.titech.ac.jp

オプションの詳細は以下のコマンドを実行して確認して下さい。

$ man sftp

CIFSによるアクセスを行う場合

また、学内端末に限りCIFSによるアクセスが可能です。

CIFSサーバは\\gshs.t3.gsic.titech.ac.jpとなっております。

なお、学内ネットワークでも、途中のルータ等でCIFSが遮断されていることがあり、その場合には使用できません。

詳細は「TSUBAME3.0利用の手引き」3.3. 学内からのCIFSによるアクセスをご確認下さい。

何に対する初心者なのかによって学習して頂く内容が異なります。

1.UNIX/Linuxの初心者の方

TSUBAME3の利用に際して、ユーザにはUNIX/Linuxの習熟度を要求しております。

UNIX/Linuxについてある程度のことがわかっている前提で、手引書などは準備されております。手引書の内容がわからない場合は、付属図書館等でUNIX/Linuxの入門図書を読んでいただき、

シェルやコマンド等の使い方を把握して下さい。一例として以下のような図書が付属図書館にあるようです。司書の方におすすめを確認頂くのもよいかと思います。

入門Unix for OS X. 第5版

新しいLinuxの教科書お配りしている資料(TSUBAME利用法 入門編(Linux基礎))も参考になるかと思います。

「端末」アプリケーションの操作についても様々な出版物があります。

ご利用のアプリケーションに合わせてご確認下さい。UNIX/Linuxの操作ならびに関連する用語を把握し、利用手引きを一読したあとに3をご確認下さい。

2.スパコン利用の初心者の方

UNIX/Linuxを利用したことがあるが、ジョブスケジューラを利用したことがない方などを想定します。

研究室のクラスタシステムなどで、ジョブスケジューラを利用したことがある方は3をご確認下さい。TSUBAME3.0利用の手引きの「5. ジョブスケジューリングシステム」をご確認下さい。

3.TSUBAME3の初心者の方

TSUBAME2.5の既存ユーザなどが該当するかと思います。

TSUBAME3とTSUBAME2.5は技術仕様が異なります。TSUBAME2.5では出来たことが同様にコンパイルしても動作しないなどございますので、

TSUBAME3の仕様をご確認して頂く必要がございます。システム構成(ハードウエア、システムソフトウエア、アプリケーション)、FAQのTSUBAME2.5からの移行について(下記のリンク)やお配りしている資料(TSUBAME利用法 入門編(Linux基礎))のTSUBAME3概要、バッチジョブ、TSUBAME3.0利用の手引きをご確認下さい。

4.isvアプリケーションの初心者の方

TSUBAME3では定期的に利用講習会を実施しております。

講習会のページをご確認下さい。

TSUBAME3ではセキュリティ対策としてセッションタイムアウト設定を行っております。

セッション(接続したターミナル)上での入力がない場合は、セッションを切断します。

GUIアプリケーションを起動して操作していても、ターミナル上の入力がない場合は落ちます。対策としては、端末側でKeepAliveの設定を行って下さい。

設定方法は利用している端末のマニュアルをご確認下さい。

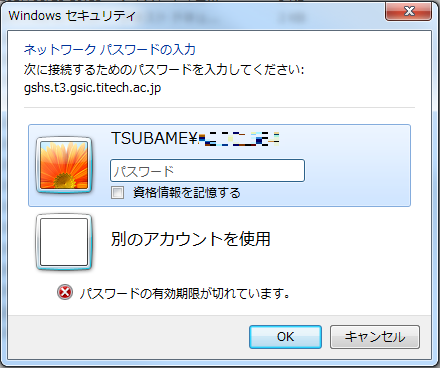

Windowsのエクスプローラーからグループディスクにアクセスしようとすると、以下のように表示されることがあります。

これは早期(2017年9月頃まで)に作成されたアカウントで発生することが確認されております。

これは、TSUBAMEアカウントのパスワードの有効期限が過ぎていることが原因です。

TSUBAMEポータルページより、パスワードの更新を行ってください。

ホームディレクトリの容量、またはグループディスクの容量が不足していることが原因です。

不要なファイルを削除するか、グループディスクを追加購入して空き領域を確保してください。

アプリケーションによっては一時ファイルの作成場所がホームディレクトリとなっている場合がありますので、ご注意下さい。

GaussianやComsolなどの一部のISVアプリケーションは、系によってですが、ホームディレクトリの25GB程度の容量では不足する場合が御座いますので、グループディスクをご利用下さい。

ホームディレクトリおよびグループディスクの利用状況は以下のFAQで確認下さい。

関連項目:TSUBAMEポイント、グループディスクの使用状況、ホームディレクトリの使用状況の確認方法

グループディスクとは

グループディスクは「TSUBAME3.0利用の手引き 3.2. 高速ストレージ領域」のことで、

TSUBAMEグループ毎にTSUBAMEポータルで設定された容量を利用できる共有ストレージです。- 利用期間:購入日から年度末(3月末)まで

例えば10TBを5月1日に購入する場合は、3,960,000ポイント必要(36,000ポイントx10TBx11ヶ月分(3月末までの期間))

月額計算となるため、月末となる5月31日に10TB購入した場合でも、1日に購入した場合と同じ3,960,000ポイント必要となります。- 購入単位:1TB単位(2,000,000inode)

上限はグループあたり300TBまで

未使用の場合は購入容量を減らすことで返ポイントを受けることが出来ます。

例えば1TBを4月に購入して、5月に全データを削除し、容量削減を行った場合は396,000ポイント(36,000ポイントx1TBx11ヶ月分(3月末までの期間)が戻ってきます。- 設定方法:TSUBAMEポータルから設定可能です

参考:「TSUBAMEポータル利用の手引き 10. グループディスクの管理」

グループディスクの猶予期間とは

グループディスクは年度末に一度リセットされ、すべてのグループディスクは読み込み/削除のみ可能な猶予状態となります。

この期間のことを猶予期間といい、通常は4月中旬頃(今年度は4/17)まで維持されます。参考:「TSUBAME3.0ポータル利用説明書(一般利用者)」5.4.1.1.グループディスクの有効期間について

前年度のデータが残っている場合に、猶予期間後に購入する場合は以下のようになります。

例えば前年度50TB購入し、45TBの容量を使用していた場合を例とします。1)猶予期間中に45TBを削除し、使用容量が0の場合

最小容量である1TBから購入可能2)猶予期間中に25TBを削除し、購入時の使用容量が20TBの場合

20TB以上から購入可能2)猶予期間中に使用容量を削除しなかった場合(購入時の使用容量が45TB)

45TB以上から購入可能*前年度データが不要な場合は猶予期間中の削除をお願いいたします。

関連FAQ

TSUBAMEポイント、グループディスクの使用状況、ホームディレクトリの使用状況の確認方法

グループディスクへのCIFS接続ができない

"Disk quota exceeded" というエラーが出力される

f_nodeでのみGPUクロックの変更が出来るようになりました。

- 利用できるクロック周波数の表示

nvidia-smi -q -d SUPPORTED_CLOCKS - クロックの変更

nvidia-smi -ac 指定クロック

例:

nvidia-smi -ac 715,999- クロックのリセット

nvidia-smi -rac デバイスは -i で指定します。

詳細はコマンドのヘルプをご覧ください。

計算ノード用ゲートウェイサーバのIPアドレス範囲は以下の通りとなっております。

131.112.3.250-131.112.3.253学内・学外のライセンスサーバを利用してTSUBAME上で計算を行う場合は上記範囲の通信を許可するように設定ください。

なお、上記アドレスは運用の都合により予告なく変更される可能性がありますのでご注意ください。

TSUBAME外(研究室など)のライセンスサーバ等への疎通を必要とするソフトウェアが動作しない場合は、お問い合わせの前にTSUBAME外かつライセンスサーバ外のネットワークから、当該ライセンスサーバと通信ができることを確認してから、以下の情報を添えてご連絡ください。

- ライセンスサーバのグローバルIPアドレス

- ライセンスサーバのポート番号 (複数ある場合は全て)

- 疎通試験を行ったホストのIPアドレス

TSUBAMEとTSUBAME外の端末間で大容量のデータを転送したい場合以下をご確認ください。

ファイルを適切なサイズに固める

大量の小さなファイルは転送速度の低下を引き起こします。tarコマンドなどで、1GB程度に固めてから転送します。

接続プロトコルを見直す

scp/sftpでパフォーマンスが出ない場合は、rsyncや、CIFS(学内のみ)で接続すると速度が改善するかもしれません。

CIFSでの接続方法については、利用の手引き内、ストレージサービス(CIFS) を参照してください。

ネットワーク経路上のボトルネックを取り除く

- リンク速度が1000Mbpsを下回るような古いLANケーブル(CAT-3、CAT-5(5eを除く))、スイッチングハブ、ルータ等があれば高速な物に置き換える。

- ルータ(WiFiルータ,NATルータ,ブロードバンドルータなど)を利用してる場合、端末をルータ外のネットワーク(東工大の場合、131.112又は172.16~31で始まるIPアドレス)に直結する。

学内のネットワークの詳細については研究室のネットワーク管理者、不明な場合はその建物、組織毎の支線管理者にお問い合わせください。

(学内利用者のみ)演習室の教育用計算機システム端末(iMac)を利用する

ネットワーク構成変更が難しい場合、HDDをGSICに持ち込んで演習室の教育用計算機システム端末(iMac)に接続してデータを転送することもできます。

ただし、利用時間が決められていますのでご注意ください。

ここではLinuxのよくあるエラーについてのFAQを記載しております。

記載しているコマンドの詳細な利用方法については各自、manコマンド等で確認してください。1.No such file or directory

必要とされるファイルもしくはディレクトリがありません。

存在しないファイル、ディレクトリ名などを指定する、タイポするなどパス指定を間違った場合等に発生します。

また、アプリケーションによっては改行コードがwindowsのCR+LFの場合に発生する場合もあります。対策

ファイル、ディレクトリ名をよく見直してください。

また改行コードの修正についてはFAQ「ジョブステータスが「Eqw」となり実行されない。」の1をご確認ください。

関連して以下のようなエラーもあります。

error while loading shared libraries: ****.so: cannot open shared object file: No such file or directory

これはプログラムが必要とするライブラリが無いもしくは読み込めない場合等に発生するエラーです。対策

プログラムにライブラリパスが通っているかをlddコマンドなどで確認してください。

環境変数LD_LIBRARY_PATHを設定する、コンパイル時にライブラリを指定するなどの対策があります。

2.command not found

入力したコマンドがありません。

環境変数PATHの設定がうまくいっていない場合やコマンドがない場合等に発生します。

TSUBAMEではmoduleコマンドを実行していないか、/etc/profile.d/modules.shファイルを読み込んでいない場合に発生する場合が多い模様です。対策

module コマンドが実行できない場合は以下のコマンドを実行してください。$ . /etc/profile.d/modules.sh自分でインストールしたプログラムなどで発生した場合は

echo $PATHコマンドで必要なコマンドがあるディレクトリのパスが通っているか確認し、パスが通っていなければ設定してください。

ホームディレクトリ($HOME)直下のhogeディレクトリを既存のPATH環境変数に追加する場合の例$ export PATH=~/hoge:$PATH

3.Permission denied

実行しようとした操作の権限がありません。

Linuxはファイル・ディレクトリ単位でユーザならびにグループ単位の権限設定がされています。

読み込み、書き込み、実行しようとした対象ファイル、ディレクトリの権限を以下のコマンドで確認してください。

(例はhogeファイルを確認する場合)$ ls -l hoge対策

システムディレクトリである/appや/libなどにファイルを作成しようとした場合等はユーザディレクトリに作成するようにしてください。

グループディスクなどのユーザディレクトリで発生する場合は権限を確認してください。

4.Disk quota exceeded

FAQ「"Disk quota exceeded" というエラーが出力される」をご確認ください。

5. Out Of Memory

メモリが不足した場合に発生するエラーです。

対策

資源タイプをよりメモリ容量が多いものに変更する。

mpiなどでノードあたりのメモリ使用量を分割する。

関連FAQ「結果ファイルのエラーメッセージについて」

エラー関連URL

"Disk quota exceeded" というエラーが出力される

qrshコマンドを実行した際のエラーについて

結果ファイルのエラーメッセージについて

エラーログに "Warning: Permanently added the ECDSA host key for IP address 'XXX.XXX.XXX.XXX' to the list of known hosts." と出力される

qsubコマンド実行時のエラーについて

segmentation faultなど、プログラム実行時のエラー対応について

ISVアプリケーションで発生したエラーに対する対処方法について

Windowsでは以下に挙げるSSHクライアントをTSUBAMEへの接続に用いることができます。

X11サーバおよびその他のLinux機能の必要性にもよりますが、上に書いてあるものほど導入コストが低くおすすめです。OpenSSH クライアント (Windows 10の機能)

Windows 10 の [設定]-[アプリ]-[オプション機能の管理] から [OpenSSH クライアント] をインストールできます。

インストール後はコマンドプロンプトからLinuxと同様の ssh, ssh-keygen 等のコマンドが利用可能です。

PuTTY

フリーのSSHクライアントソフトウェアです。

X11サーバは含まれていないため、X11アプリケーションを利用する際には別途X11サーバをインストールする必要があります。

SSH鍵の作成方法についてはこちらのFAQ記事をご参照ください。MobaXterm

SSHクライアントとX11サーバを内包したソフトウェアです。

TSUBAME上のX11アプリケーションのほとんどが問題なく動作するようです。

SSH鍵の作成は、PuTTYと同様ですので、PuTTYのFAQ記事をご参照ください。Window Subsystem for Linux

Windows 10 ストアでLinuxディストリビューション(Ubuntu, OpenSUSE等)をダウンロードすることで、Windows上にLinux環境を構築することができます。

X11サーバおよびその他のLinux環境も同時に構築することとなります。

Linux環境から ssh, ssh-keygen 等のコマンドが利用可能です。Cygwin

Windows上でLinux環境を再現するソフトウェアです。

Cygwin環境から ssh, ssh-keygen 等のコマンドが利用可能です。

長らくCygwinを使っていたなどの事情がなければ、TSUBAMEへの接続は他のソフトウェアで行うことを強く推奨いたします。

ログインノードでは1ユーザ当たり50プロセスの制限をかけております。

その為、その制限を超えたプロセスを生成した場合このようなエラーが表示されます。

詳細につきましては、ログインノードでCPUを占有する利用は行わないでくださいをご参照下さい。

注意: 本記事はグループディスク(/gs/hsX/)に関してのものです、ホームディレクトリで以下のサンプルを実行しないでください。

利用者が自分のファイルのオーナーを変更することはできません。そのためグループパーミッションを変更して読み書きできるように設定してください。ポイントとしては、

- 一番上位のディレクトリだけではなく、ディレクトリ以下のすべてのファイル、ディレクトリも権限を変更すること。

- ファイルには読み込み(r)だけでなく書き込み(w)権限を追加すること。書き込み(w)がないと後で消去できません。

- ディレクトリには読み込み(r)だけでなく書き込み(w)と実行(x)も追加すること。実行(x)がないとディレクトリにアクセスできません。

以下にコマンド例を示します。ファイルの元々のパーミッションによってはエラーが出ることがあるため、その場合は出力が変わらなくなるまで再実行してみてください。

/gs/hsX/tgX-XXXXXX/以下の自分のディレクトリを探してグループのメンバーが読み書き参照ができるようにする。

find /gs/hsX/tgX-XXXXXX/ -type d -user $USER ! -perm -2770 -print0 | xargs -r0 chmod -v ug+rwx,g+s/gs/hsX/tgX-XXXXXX/以下の自分のファイルを探してグループのメンバーが読み書きできるようにする。

find /gs/hsX/tgX-XXXXXX/ -type f -user $USER ! -perm -660 -print0 | xargs -r0 chmod -v ug+rw/gs/hsX/tgX-XXXXXX/以下の自分のファイルを探して所有グループをTSUBAMEグループに合わせる。

find /gs/hsX/tgX-XXXXXX/ -user $USER ! -group (TSUBAMEグループ名) -print0 | xargs -r0 chgrp -v (TSUBAMEグループ名)上記のコマンドを自動で実行するスクリプトを用意しました。なお、本スクリプトの動作は保証しませんので、自己責任でご利用ください。

module load takeovertool

cd /gs/hsX/tgX-XXXXXX

fixperm

普段は、WinSCPなどのグラフィカルな操作(GUI)が可能なソフトウエアを利用するのが簡単かと思いますが、たくさんのデータを一括で同期したいと言った要望には rsync コマンドをご利用ください。rsync コマンドの利点は差分だけを転送する点が挙げられます。何らかの理由でファイル転送が中断した場合でも続きから再開できますし、一定期間後に再度実行すれば、内容の変更のあったファイルだけを転送できます。コピー元から削除されたデータはコピー先でも削除して完全に同期することも可能です。

以下にコマンド例を示します。コマンドが途中で失敗している場合を考慮し、ログを確認したり、複数回実行するのが良いでしょう。

手元の端末のデータをTSUBAMEに同期する。

rsync -auv (コピー元のディレクトリ) (自分のログイン名)@login.t3.gsic.titech.ac.jp:(コピー先のディレクトリのフルパス)TSUBAMEのデータを手元の端末に同期する。

rsync -auv (自分のログイン名)@login.t3.gsic.titech.ac.jp:(コピー元のディレクトリのフルパス) (コピー先のディレクトリ)

謝辞の記載方法の文例は下記のページをご参照ください。

あくまでも例示ですので、他のスパコンや研究資金等の謝辞記載に合わせて記載を調整いただいても構いません。また、TSUBAMEの活用状況を把握するため、TSUBAMEポータルから書誌情報などの利用成果報告もお願いいたします。

利用報告の投稿方法は、下記利用の手引きをご覧ください。

1ディレクトリあたりのファイル数が多くなると、当該ディレクトリ配下のファイルに対するメタデータ操作(ファイルの作成・削除・オープン)の際に処理時間が増大したり、ファイルシステムがエラーを出すことでファイルを作れなくなるなどの事象が発生します。

プログラムのファイルアクセス性能の面でも不利になりますので、 グループディスクを利用する場合でも、多くとも1ディレクトリ当たり10万ファイルを下回るように、ファイルを階層的に配置することをお勧めいたします。

例:

- NG: 000000.dat ~ 999999.dat

- 1ディレクトリに100万ファイルをフラットに配置すると、ファイルアクセス時の負荷が増大し、性能低下・障害の原因になります。

- OK: 000/000000.dat ~ 000/000999.dat, 001/001000.dat ~ 001/001999.dat, …

- 階層的に配置することで、1ディレクトリ当たりのファイル数を1000程度に抑えることで、ファイルシステム操作のコストを最小化できます。

- NG: 000000.dat ~ 999999.dat

アカウント

ポータルのユーザ追加画面で目的のユーザが検索できない場合は次のような原因が考えられます

- TSUBAMEのアカウント申請が完了していない

TSUBAMEアカウントは入学に伴い自動的に作られるものではなく、各ユーザが東工大ポータル経由でアカウントを申請する必要があります。アカウント申請が完了するまではグループ管理者によるアカウント検索に出てきません。

また、当該利用希望者がアクセスカード所持者の場合、TSUBAMEポータルからのアカウント申請は東工大職員・学生と同等の課金優遇を行う身分を持っている場合のみとなります。また、機械的に認可されるわけではなく、身分を証明する書類の送付が必要となりますので、当該ページの説明を参考に手続きを完了させてください。

アカウント申請方法の詳細は、アカウント取得方法をご参照ください。 - ユーザの属性とTSUBAMEグループの属性が一致していない

TSUBAMEグループの作成時に、グループ区分としてどのようなユーザが所属できるかを設定し、その条件に外れたユーザの追加は行えません。例えば「東工大に在籍する教職員、学生等のみのグループ」には学外ユーザを追加できません。このような場合、「このユーザには参加資格がありません。」と表示されます。グループの区分は事後的に変更することはできませんので、当該ユーザを加入させることができる適切な属性のグループを作成してください。

なお、HPCIによる利用者が新たに競争的資金による東工大との共同研究を開始した場合など、既存アカウントに新たな資格が発生した場合には、その資格に基づくアカウント申請時に既存のアカウント名を付記することで、当該のグループに所属することができるようになります。

- TSUBAMEのアカウント申請が完了していない

進学等でログイン名の変更が必要なアカウントは、

毎月1日時点の情報を用いてその月の10日頃にGSICが一括で変更いたします。そのため利用者が個別に申請処理を行なったり、新規にTSUBAMEアカウントを取り直したりする必要はありません。

変更されるまでは以前のログイン名をそのままご利用ください。なお情報元となる東工大ICカードの発行タイミングによってはタイミングが合わず変更が完了するまでに多くの期間を要する場合があります。

何か特別な事情により早く変更してほしい場合はお手数ですがお問い合わせフォームよりご連絡ください。

関連リンク:

アカウント取得方法/アカウントのログイン名

https://www.t3.gsic.titech.ac.jp/getting-account#login_name

TSUBAMEポイント・TSUBAMEポータル

- JavaScriptが無効になっている場合には、有効にして再度お試しください。

- Internet Explorerを利用している一部の環境で、TSUBAMEポータルのアカウント申請画面が正常に表示されない問題がありました。2017/8/3に修正されておりますが、何か問題がありましたら、お知らせください

- お手元のブラウザで動作しない場合には、EdgeやChrome, Firefox, Safariなどの別のブラウザを用いてご利用ください。

グループ代表者よりアカウントの招待を受け,「TSUBAME3.0TSBAMEグループ利用者招待」のメールを受け取りURLをクリックしたがログイン画面が表示されてしまい,グループに参加することができない現象に関する対応方法です。

- そのままログインしていただき、ログインした状態のブラウザを開いたまま、再度リンクをクリックしてください。

- メーラによって、末尾の「=」がリンクに含まれない場合があります。その場合は、「=」を含めてブラウザにコピーペーストしてください。

- 招待URLの期限は1週間となっております。期限が切れた場合は、再度招待の操作を行ってください。

ポータルシステムからユーザ、グループ追加後、ログインノードなどに情報が反映されるまでに 最大で5分かかる場合がございます。ログインノードなどから情報更新されない場合には、5分程度、待ってから操作いただけますようお願いします。

ここで言うポイントはTSUBAME3上で利用されるポイントのことを指します。

ポイントはTSUBAME3にジョブを投入した際やグループディスクを購入した際に消費されます。

ポイントの確認、消費量について簡単に説明します。

詳細はTSUBAMEポータル利用の手引きをご確認下さい。

1.ポイントの確認方法について

ポイントはTSUBAME3ポータルおよびコマンドから確認ができます。

ポータルの場合は以下を確認できます。- バッチジョブスケジューラに投入したジョブごとの消費ポイント数

- グループディスク購入で消費したポイント

コマンドの場合はFAQTSUBAMEポイント、グループディスクの使用状況、ホームディレクトリの使用状況の確認方法をご確認ください。

2.ポイントの消費量について

ポイントは東京工業大学学術国際情報センター計算機システム利用細則第13条に基づいて消費されます。

実際に消費されるポイントはユーザや利用方法によって異なります。

詳細は東京工業大学学術国際情報センタークラウド型ビッグデータグリーンスーパーコンピュータ利用料の課金等に関する取扱いを確認して下さい。

3.ポイントの購入

ポイントはTSUBAME3ポータルから購入ができます。

詳細はTSUBAMEポータル利用の手引きをご確認下さい。

4.ポイントの有効期限について

年度内に購入したポイントはその年度末で失効いたします。詳しくは下記を参照して下さい。8.1. ポイントの購入可能期間・有効期間について

https://helpdesk.t3.gsic.titech.ac.jp/manuals/portal.ja/point/#point_expiration課金等に関する取扱い「第6条 ポイントは,購入した年度に限り有効とする」

http://www.somuka.titech.ac.jp/reiki_int/reiki_honbun/x385RG00001339.html

「予算責任者の追認待ち」は予算責任者が持つ予算を、申請者が利用することを承認する処理待ちとなります。

ポータルの支払いコード申請にてステータスが「予算責任者の追認待ち」となり、手続きが止まっている場合は

ポータルで登録した「予算責任者」様にご確認下さい。

TSUBAMEポイント、グループディスクの使用状況、ホームディレクトリの使用状況を確認するコマンドが準備されました。

準備されたコマンドは「t3-user-info」、ログインノード(login0,login1)でのみ実行できます。(計算ノードでは実行できません)それぞれの確認には以下、例に示すコマンドオプションが必要となります。

GSICUSER@login1:~> t3-user-info

usage: t3-user-info [command] [sub command] [option]

[command] [sub_command] [option]

group point : Output the points of the Tsubame Group.

: Without option : show all belonging groups.

[-g] <group name> : extract the specified group.

disk group : Output the purchase amount and use amount of Tsubame Group disk.

: Without option : show all belonging groups.

[-g] <group name> : extract the specified group.

home : Output the use limit and used of the home disk.- グループのポイントを確認する場合のコマンド例

以下の例は、グループ「GSIC_GROUP」、「GSIC」に参加している「GSICUSER」ユーザがコマンドを実行した場合となります。

実際にコマンドを実行する際は「ご自分のユーザ名」、「参加されているグループ名」を使用してください。1.参加しているグループすべての状況を確認する場合

参加しているグループの「GSIC_GROUP」、「GSIC」のTSUBAMEポイントがそれぞれ17218631、95680000、仮ポイントがそれぞれ0、124000である状況が確認できます。

GSICUSER@login1:~> t3-user-info group point

gid group_name deposit balance

--------------------------------------------------------------

0007 GSIC_GROUP 0 17218631

0451 GSIC 124000 9956800002.指定グループの状況を確認する場合

指定したGSIC_GROUPグループのTSUBAMEポイントが17218631、仮ポイントが124000である状況が確認できます。

GSICUSER@login1:~> t3-user-info group point -g GSIC_GROUP

gid group_name deposit balance

--------------------------------------------------------------

2007 tga-hpe_group00 124000 17218631- グループディスクの使用状況を確認する場合

指定したGSIC_GROUPグループでは、/gs/hs1のみ購入し、100TBのクォータ制限のうち、約60TB利用し、

inode制限については、2億のクォータ制限のうち、750万利用している状況が確認できます。GSICUSER@login1:~> t3-user-info disk group -g GSIC_GROUP

/gs/hs0 /gs/hs1 /gs/hs2

gid group_name size(TB) quota(TB) file(M) quota(M) size(TB) quota(TB) file(M) quota(M) size(TB) quota(TB) file(M) quota(M)

--------------------------------------------------------------------------------------------------------------------------------------------------

0007 GSIC_GROUP 0.00 0 0.00 0 59.78 100 7.50 200 0.00 0 0.00 0- ホームディレクトリの使用状況を確認する場合

25GBのクォータ制限のうち、7GB利用し、

inode制限については、200万のクォータ制限のうち、約10万利用している状況が確認できます。GSICUSER@login1:~> t3-user-info disk home

uid name b_size(GB) b_quota(GB) i_files i_quota

---------------------------------------------------------------

0177 GSICUSER 7 25 101446 2000000

TSUBAME3ではジョブの投入時に必要と見込まれるTSUBAMEポイントを「仮ポイント」として徴収し、ジョブの終了後に実際の消費ポイントを清算します。

TSUBAMEポイントの消費・返却タイミングは以下の通りとなります。- ジョブの投入時・qrshコマンド実行時

ジョブが消費しうる最大のTSUBAMEポイントを仮ポイントとして徴収します。 - ジョブの終了時

以下の3通りで仮ポイントの清算タイミングが異なります- ジョブが通常通り終了したとき・ジョブの実行開始後にqdelコマンドでキャンセルしたとき

ジョブが実際に使用した時間に基づき、消費ポイントを再計算し、差額を即時返却します。 - ジョブの実行開始前にqdelコマンドでキャンセルしたとき、qrshコマンドの開始が失敗したとき

仮ポイントが徴収されたままとなります。仮ポイントはキャンセル・実行失敗から3日以内に自動的に返却されます。

3日以上経ってもTSUBAMEポータルにおける表示が「処理中」のまま変わらない場合は、お問い合わせください。 - システム異常によりスケジューラもしくはシステム管理者によるジョブ削除が行われたとき

基本的には a. と同様ジョブが削除された時刻に基づき清算されます。

明らかにシステム事由のキャンセルである場合、お問い合わせいただいたものについては無駄になったTSUBAMEポイントを補償いたします。

- ジョブが通常通り終了したとき・ジョブの実行開始後にqdelコマンドでキャンセルしたとき

TSUBAMEポイントに関するお問い合わせの際には、以下の事項を記載して問い合わせフォームよりご連絡ください。

- ジョブを投入したTSUBAME3グループ

- ジョブを投入したユーザ

- ジョブID

- ジョブの投入時・qrshコマンド実行時

例えばTSUBAMEグループへの招待メールにおける承認ページへのリンクなど、TSUBAMEポータルによって自動生成されたリンクが利用者のブラウザ、メーラ環境などにより、正しく機能しない場合があります。具体的には、

- TSUBAMEポータルのログインページが表示されて正しいページに遷移しない。

- 「参照したURLは表示期限が切れました」などと表示される。

このような症状が見られた場合、東工大ポータルからTSUBAMEポータルに移動しログインした状態のウインドウのアドレスバーに対して、メールで送られてきたアドレスを改行が含まれていないかや末尾が途切れていないかを確認しつつ、コピー&ペーストしてEnterキーを押してみてください。

それでも正しく機能していないと思われる場合はお手数ですがお問い合わせフォームに

- あなたのTSUBAMEアカウントのログイン名

- 送られてきたメールの送付日時

- 最初にリンクをクリックしたおおよその日時

- その他関連するTSUBAMEグループ情報など

をご連絡ください。

TSUBAMEポータル上で支払コードを申請した際に、内容に不備がある場合、TSUBAMEポータルより、申請却下のお知らせをお送りしています。

「システム管理者からのコメント」として、却下した理由をお知らせしていますので、内容をご確認のうえ、必要に応じて修正して再申請してください。

以下に典型的な却下理由と再申請の際に確認いただきたい事項を例示します。1. 該当する予算の存在を確認できませんでした

支払コード申請に記入された予算コードおよび予算名称の組の実在性を担当者が財務会計システム上で確認しましたが、誤記の可能性を含めて該当する予算を見つけることが出来なかった場合に上記のメッセージをお送りしています。

予算が外部資金や科研費等の場合、今年度分の予算コードが物品等請求システム上で既に作成されているかをご確認ください。

また、予算コード・予算名称・予算部局・予算区分・予算責任者の記載に誤りがあると、当方で検索できなくなりますので、正しく記載してください。

特に、予算コード(32桁)および予算名称は、2020年度からの財務会計システムでは桁数が多く、転記の際に一部が欠落している申請がありますので、以下の手順で取得されることを強くお勧めいたします。- 新物品等請求システムにログイン

- 予算管理 を選択

- 予算執行状況確認 を選択

- CSV作成 を選択

- 出力されたCSVファイルの「予算コード」(32桁)および「予算名称」を転記

2. 予算コードがあることまでは確認できましたが、○○が異なっていました

支払コード申請に記入された内容から、該当すると思われる予算が見つかりましたが、一部項目が財務会計システム上の登録内容と一致しておらず、誤字として担当者の裁量で訂正可能な範囲を超えて誤っていた場合に上記のメッセージをお送りしています。

前項を参考に、物品等請求システムで表示される登録内容を確認のうえで、正しい内容で再申請してください。

なお、○○の部分が予算責任者氏名となっている場合、次項をご参照ください。3. 予算コードがあることまでは確認できましたが、予算責任者氏名が異なっていました

支払コード申請の際に記載された予算責任者のアカウント情報と、財務会計システム上の予算責任者の情報が一致していない場合に上記のメッセージをお送りしています。

TSUBAMEでは、請求に関する諸連絡を確実に行えるよう、TSUBAMEの計算資源を直接利用しない方を含め、予算責任者の方にTSUBAMEアカウントを取得、利用規約に同意いただき、アカウント情報を記入いただいています。

また、支払コード利用者(TSUBAMEグループのグループ管理者(メイン))と予算責任者が異なる場合には、予算使用を許可されていることを事前に確認するため、予算責任者の方にTSUBAMEポータル上で支払コードの申請の承認(追認)処理をしていただいております。4. 費目がその他ではないため、却下します (科研費)

支払コード申請に科研費の「その他」以外の費目(物品費・旅費・人件費)の予算コードを指定した際に上記のメッセージをお送りしています。

科研費は費目別に4種類の予算コードがありますが、TSUBAMEの計算機使用料は「その他」の費目に分類されます。 (府省共通経費取扱区分表内、「研究機関内の施設・設備使用料」に相当)

このため、「その他」以外の費目による支払コード申請は費目誤りとして却下させていただいております。5. 教職員以外の方は、自身が予算責任者となっている申請に限らせていただいております

教職員以外の方が、自身が予算責任者となっていない予算について支払コード申請を行った際に上記のメッセージをお送りしています。

教職員以外の方は、ご自身が予算責任者となっている予算(学振特別研究員の科研費等)以外の予算について、TSUBAMEの支払責任者となることができません。

そのような予算を利用する必要がある場合は、適切な教職員に支払責任者となることを依頼し、支払コードを再申請してもらってください。

なお、TSUBAMEグループに支払コードを紐づけできるのは、グループ管理者(メイン)が支払責任者となっている支払コードのみですので、既にTSUBAMEグループを作成済みである場合は必要に応じてグループ管理者(メイン)の変更を実施してください。6. 既に新規請求事項発生可能期間を過ぎています

申請された予算に関して、既にTSUBAMEポイントの新規購入ができない状態にあるときに上記のメッセージをお送りしています。

TSUBAMEでは、TSUBAMEポータルにおける購入操作を月毎にまとめて翌月以降に予算の振替処理を行っております。

この振替処理が予算の使用可能期間(年度内かつ研究期間内)に収まるよう、支払コードの利用可能期間を設けておりますが、この期間を既に過ぎており、ポイントの購入に利用できない予算については、申請をお断りしております。

なお、1~3月の期間は、法人運営費と奨学寄附金のみ支払コードの登録・利用が可能ですが、1~3月の利用分は翌年度の同予算への請求になりますので、予算の残額管理の際にはご留意ください。7. 既に同じ利用年度かつ同じ予算コードの申請をシステム管理者が承認済みです

既に同一の予算を対象とした支払コードが承認されているときに上記のメッセージをお送りしています。

承認済みの支払コードをご利用ください。

ジョブの実行(スケジューラ)

エラーによって対応方法が異なります。

-

qsub: Unknown option

「qsub: Unknown option」エラーは、qsubコマンドのオプション以外にも、ジョブスクリプトの「#$」で始まる行の記述に誤りがあるときにも発生します。

よくある間違いとして「=」で内容を指定するオプションの「=」の前後にスペースを入れた場合にこのエラーが繰り返し表示されます。「=」前後のスペースを削除してみてください。-

Job is rejected, h_rt can not be longer than 10 mins with this group

-gオプションやnewgrpなどでTSUBAMEグループを指定しない場合は「お試し実行」となります。

「お試し実行」は10分以内のみですが、指定されているh_rt オプションが10分以上を指定しております。

「お試し実行」の場合はh_rt オプションを0:10:0のように修正下さい。

「お試し実行」以外で実行したいのであれば、-gオプションやnewgrpなどでTSUBAMEグループを指定してください。

*この場合は適切なTSUBAMEグループに参加していること、TSUBAMEグループにポイントがあることを確認して下さい。

TSUBAMEグループについてはTSUBAMEポータル利用の手引き 「6. グループの管理」をご確認下さい-

Unable to run job: Job is rejected. h_rt must be specified.

h_rtオプションの記載がないため実行できません。時間設定を行い、実行ください。

-

Unable to run job: the job duration is longer than duration of the advance resavation id AR-ID.

予約時間よりも長い時間を指定したために発生したエラーです。

下記FAQの予約についてをご確認ください。

関連FAQ

バッチジョブスケジューラの仕様について-

error: commlib error: can't set CA chain

ホームディレクトリ内に自動生成されているジョブの投入に必要な証明書ファイルが存在しない、もしくは破損しているために発生したエラーです。

このエラーが発生した場合は以下を実行後、TSUBAMEにログインしなおすことで再生成されますのでお試しください。

$ cd $HOME

$ mv .sge .sge.back

-

システムの障害の可能性もありますがジョブスクリプトのミスによることがあります。以下の点をご確認ください。

ジョブの詳細状況は以下のコマンドで確認ができます。

$ qstat -j ジョブID | grep error確認後、「Eqw」ステータスのジョブは qdel で削除してください。

原因の切り分けと修正を行いジョブを再投入してください。エラーの場合の例を以下にあげます。

ファイルパーミッションがない場合のエラー例error reason 1: エラー発生時間 [5226:17074]: error: can't open stdout output file "原因のファイル": Permission denied改行コードの問題やディレクトリが存在しないおよびジョブスクリプトが不正な場合のエラー例

error reason 1: エラー発生時間 [5378:990988]: execvp(/var/spool/uge/ホスト名/job_scripts/ジョブID, "/var/spool/uge/ホスト名/job_scripts/ジョブID") failed: No such file or directory1. ジョブスクリプトの改行コードがUNIX形式(LF)でない

改行コードがwindowsのCR+LFに設定されている場合も発生いたしますので、実際のスクリプトで合わせてご確認ください。

以下のコマンドで確認ができます。$ file スクリプトファイル名#CR+LFの場合の出力

スクリプトファイル名: ASCII text, with CRLF line terminators

#LFの場合の出力

スクリプトファイル名: ASCII text

catコマンドでも確認ができます

$ cat -e スクリプトファイル名#CR+LFの場合の出力

行末が^M$と表示されます。#!/bin/bash^M$

#$ -cwd^M$

#$ -l f_node=1^M$

#$ -l h_rt=0:10:00^M$

./etc/profile.d/modules.sh^M$

module load intel^M$#LFの場合の出力

行末が$と表示されます。#!/bin/bash$

#$ -cwd$

#$ -l f_node=1$

#$ -l h_rt=0:10:00$

./etc/profile.d/modules.sh$

module load intel$

改行コードの対策としては、以下があります。- Windowsでスクリプトを編集しない

- Windowsでスクリプトを編集する場合は改行コードに対応したエディタを利用し、改行コードを必ず確認する

- nkfで実行前に改行コードをLFに修正する

- LF以外であった際は下記のコマンドで修正ください。

$ nkf -Lu file1.sh > file2.sh

※file1.shは変換したいスクリプトファイル、file2.shは変換後のスクリプト出力先ファイルです。file2.shはfile1.shとは異なるファイル名でなければなりません。同一ファイル名を指定するとファイルが破損しますのでご注意ください。

2. 実行するディレクトリなどが存在しない

ジョブスクリプトで記述されている実行ディレクトリが存在しない場合に発生します。以下のコマンドで確認ください。

確認後、スクリプトを適切に修正下さい。$ qstat -j ジョブID | grep ^errorerror reason 1: 09/13/2017 12:00:00 [2222:19999]: error: can't chdir to /gs/hs0/test-g/user00/no-dir: No such file or directory3. バックグラウンドジョブ("&"付き)でジョブスクリプトが記載されている

以下の様にバックグラウンドジョブ("&"付き)で記載し投入された場合、実行されません。

例)

#!/bash/sh

#$ -cwd

#$ -l f_node=1

#$ -l h_rt=1:00:00

#$ -N test

./etc/profile.d/modules.sh

module load intel

./a.out &4. ファイルパーミッションが無い

プログラムが利用するファイルに適切なパーミッションを設定下さい。例) 自分にreadと実行権限を付与

$ chmod u+rx スクリプトファイル名

5. ディスククォータ

グループディスクのクォータをご確認下さい。

1TBあたりの保存可能ファイル数 (iノード数) の上限は 2,000,000です。確認方法は下記FAQを参照下さい。

ログインノードに投入したプロセスについては

FAQ「間違って実行してしまったプログラムの停止方法について」をご確認下さい。1.qsubコマンドを発行した場合に表示されたjob-IDを把握している場合

qdelコマンドを実行してジョブを停止して下さい。

qdel [job-ID]と打つと指定されたjob-IDのジョブが停止します。例:job-IDが10056の場合

$ qdel 100562.job-IDがわからない場合

qstatコマンドを実行して停止したいジョブのjob-IDを確認して下さい。

ユーザがバッチジョブスケジューラに投入し、完了していないジョブの一覧が表示されるので、

削除したいジョブのjob-IDを控えて、1.の手順を実行下さい。例:GISCユーザが実行しているジョブを確認した場合

$ qstat

job-ID prior name user state submit/start at queue jclass slots ja-task-ID

------------------------------------------------------------------------------------------

10053 0.555 ts1 GSIC r 08/28/2017 22:53:44 all.q 28

10054 0.555 ts2 GSIC qw 08/28/2017 22:53:44 all.q 112

10055 0.555 ts3 GSIC hqw 08/28/2017 22:53:45 all.q 56

10056 0.555 eq1 GSIC Eqw 08/28/2017 22:58:42 all.q 7TIPS.ジョブのステータスについて

Eqwとなっているジョブはユーザが削除して下さい。

原因についてはジョブステータスが「Eqw」となり実行されない。を確認下さい。

hwqにしたい場合はFAQの「依存ジョブの投入方法について」を確認下さい。

state 説明 r 実行中のジョブ qw 計算資源が空いておらず、順番待ちとなっているジョブ hqw 他のジョブとの依存関係があり、他のジョブの終了待ちとなっているジョブ Eqw 何らかの理由でエラーとなっているジョブ t qwからrへ移行中のジョブ

ジョブモニタリングの積み上げグラフをご確認下さい。

凡例は以下のようになっておりますので、緑色の状況を確認することで空きがあるのか確認できます。緑色:空いているノード

青色:実行中ノード(通常ジョブ)

桃色:予約ノード(未実行ノード)

赤色:予約ノード(実行中ノード)

TSUBAME3では計算ノード用のスクラッチ領域として以下を提供しております。

詳細は利用の手引きの計算ノード上のストレージの利用をご確認下さい。1. ローカルスクラッチ領域

計算ノード上でのみ割り当てられる環境変数$TMPDIRがローカルスクラッチ領域です。

$TMPDIRは通常、/scr 以下のジョブごとに固有のディレクトリになります。/scr直下は書き込みが出来ません。

2. 共有スクラッチ領域

資源タイプFのf_nodeを利用したバッチスクリプトの場合のみ利用可能です。

#$ -v USE_BEEOND=1を指定してください。

/beeondディレクトリが割り当てられます。

3. /tmp領域

/tmpディレクトリについては2GBの容量制限があります。

大容量スクラッチファイルの作成時などの際に実行プログラムのハングアップなどの問題が発生する懸念があります。

1.および2.のスクラッチディレクトリのご利用を検討ください。

計算ノードへのSSHはf_nodeのみ可能です。

MPI通信をする際にSSHを利用する仕様のアプリケーションを実行する際はf_nodeをご利用下さい。

ANSYS fluentなどisvアプリケーションでもございます。

手引書の5.7SSHログインに記載がございます。

A-1という名前のバッチジョブが終了次第、バッチジョブA-2を実行したい場合は

下記のように-hold_jidオプションを利用してジョブを投入して下さい。$ qsub -N A-1 MM.sh

$ qsub -N A-2 -hold_jid A-1 MD.sh投入後にqstatコマンドを実行するとステータスは「hqw」となります。

バッチ実行により一つジョブ中で複数の計算を実行したい場合、例えば、exec1、exec2、exec3、exec4 という4つのコマンドを一括実行したい場合はバッチスクリプトを次のように記述します。

#!/bin/sh

#$ -cwd

#$ -l f_node=1

#$ -l h_rt=1:00:00

. /etc/profile.d/modules.sh

module load cuda/8.0.61

module load intel/17.0.4.196

exec1 &

exec2 &

exec3 &

exec4 &

wait上記はあくまで一例です。

尚、異なるディレクトリに配置されているプログラムを一括実行したい場合は、実行ファイルをパスから記述する必要があります。

例えば、ホームディレクトリの folder1にあるa.outを直接実行したい場合は、~/folder1/a.out &と指定します。

実行ファイルのディレクトリに移動して実行する必要がある場合は、cd ~/folder1

./a.out &または

cd ~/folder1 ; ./a.out &とすればよいです。

スクリプトファイルの最終行が & で終了する場合は、ジョブが実行されません。

スクリプトの最後の wait コマンドを忘れずに記述してください。

Q.qsubコマンドを実行する際にマニュアル記載の通り、下記のようにコマンドを叩くと

qsubコマンドを実行する前にログインノード上で計算が始まってしまいます。GSICUSER@login1:~> #!/bin/bash

GSICUSER@login1:~> #$ -cwd

GSICUSER@login1:~> #$ -l f_node=2

GSICUSER@login1:~> #$ -l h_rt=0:30:0

GSICUSER@login1:~> . /etc/profile.d/modules.sh

GSICUSER@login1:~> module load matlab/R2017a

GSICUSER@login1:~> matlab -nodisplay -r AlignMultipleSequencesExampleA.バッチスクリプトを作成して、作成したバッチスクリプトをqsubコマンドで投入して下さい。

上記の場合は、login1のシェル上で実行しております。上記のバッチスクリプトやシェルなどの用語がわからない場合は

初心者なのですが、何をすればよいのかわかりませんのUNIX/Linuxの初心者の方をご確認下さい。

qrsh実行時のエラーについて説明します。

1.Your "qrsh" request could not be scheduled, try again later.

このエラーはインタラクティブ実行に必要なf_nodeの空きがないことを示します。

f_nodeに空きができるまで待ち、再度実行して下さい。

利用状況はFAQの「計算ノードの混雑状況を確認したい」を参照して下さい。2.Job is rejected. You do NOT have enough point to finish this job

このエラーはノード確保に必要なTSUBAMEポイントが無いことを示します。

TSUBAMEポータルからポイント状況をご確認下さい。

関連:TSUBAMEポイントが返却されるまでどのくらいの日数がかかりますか?

3.Unable to run job: unable to send message to qmaster using port 6444 on host "jobconX": got send error.

Exiting.このエラーはUGEサーバ側が高負荷の場合に発生します。

時間を開けて再度実行ください。

バッチジョブスケジューラに投入後のログに出力される以下のようなメッセージに対する確認方法をご説明します。

/var/spool/uge/hostname/job_scripts/JOB-ID: line XX: Process-ID Killed Program_Name

qacct コマンドによる確認を行います。

$ qacct -j JOB-ID

ユーザGSICUSER00がq_nodeに投入したジョブを確認したコマンド結果の例(一部抜粋)

下記項目の詳細についてはmanコマンドで確認下さい。

==============================================================

1.メモリ資源を超過した場合の例

$ qacct -j 4500000

qname all.q

hostname r0i0n0

group GSIC

owner GSICUSER00

project NONE

department defaultdepartment

jobname SAMPLE.sh

jobnumber 4500000

taskid undefined

account 0 0 1 0 0 0 3600 0 0 0 0 0 0

priority 0

cwd /path-to-current

submit_host login0 or login1

submit_cmd qsub -A GSICGROUP SAMPLE.sh

qsub_time %M/%D/%Y %H:%M:%S.%3N

start_time %M/%D/%Y %H:%M:%S.%3N

end_time %M/%D/%Y %H:%M:%S.%3N

granted_pe mpi_f_node

slots 7

failed 0

deleted_by NONE

exit_status 137

maxvmem 120.000G

maxrss 0.000

maxpss 0.000

arid undefined

jc_name NONEこの例では、exit_statusとaccountおよびmaxvmemに注目します。

exit_statusを確認することで、何が原因でジョブが停止したかを確認できます。

例のexit_status 137 は128+9を示しますが、これだけだと多岐にわたるため、切り分けはできません。

そこでaccountおよびmaxvmemを確認します。

(2018/12/7修正 :granted_peのみでは資源タイプが不明となったため修正)

accountの「0 0 1 0 0 0」はどの資源タイプをどのくらいの量、利用したかを示します。

スペース区切りでそれぞれf_node,h_node,q_node,s_core,q_core,s_gpuの資源タイプを示し、数字は資源量を示します。この例ではq_nodeを1つ利用しています。

maxvmemは最大メモリ使用量を示します。

資源タイプq_nodeは利用手引きを確認すると60GB利用できますが、例では120GB利用しようとしたことがわかります。

TSUBAMEでは、資源割り当て以上に利用した場合はシステム側でKILLされる仕組みとなっているので、それが原因であると推察できます。

2.確保した時間を超過した場合の例

$ qacct -j 50000000

qname all.q

hostname r0i0n0

group GSIC

owner GSICUSER00

project NONE

department defaultdepartment

jobname SAMPLE.sh

jobnumber 50000000

taskid undefined

account 0 0 1 0 0 0 600 0 0 0 0 0 0

priority 0

cwd /path-to-current

submit_host login0 or login1

submit_cmd qsub -A GSICGROUP SAMPLE.sh

granted_pe mpi_f_node

slots 7

failed 0

deleted_by NONE

exit_status 137

wallclock 614.711

maxvmem 12.000G

maxrss 0.000

maxpss 0.000

arid undefined

jc_name NONEこの例では、exit_statusとaccount、wallclockに注目します。

exit_statusを確認することで、何が原因でジョブが停止したかを確認できます。

例のexit_status 137 は128+9を示しますが、これだけだと多岐にわたるため、切り分けはできません。

そこでaccount、wallclockに注目します。

accountのスペース区切りで7つめの数字は資源を確保した時間(秒)を示します。

この例では600秒です。

wallclockは経過時間を示し、この例では614秒で終了しております。

資源確保時間内に計算が終了しなかったため、システム側でKILLされたと推察できます。

関連FAQ:Linuxのよくあるエラーについて

本FAQではqrshでX転送する方法についてご説明します。

本方法にてf_node以外を利用したGUIアプリケーションの利用が可能となります。

以下の手順にて実行下さい。(前準備)

X転送を有効にしてログインノードにsshします。

参考:FAQ「Xアプリケーション(GUI)が動作しません」の1,2

1.ログインノードにログイン後、以下のコマンドを実行します。

下記の例ではGSICUSERがlogin1からs_coreを1時間利用する例になります。

青字の箇所を、ご自分のグループ、利用したい資源および時間に変更してご利用下さい。※2020年4月に実施したスケジューラの更新に伴い、 qrsh 実行時に `-pty yes -display "$DISPLAY" -v TERM /bin/bash` を明示的に指定する必要がなくなりました。

GSICUSER@login1:~> qrsh -g GSICGROUP -l s_core=1,h_rt=0:10:00

2.利用したいXアプリケーションを実行します。

例としてimagemagickを実行しますGSICUSER@r1i6n3:~> . /etc/profile.d/modules.sh

GSICUSER@r1i6n3:~> module load imagemagick

GSICUSER@r1i6n3:~> display

■注意事項

GUIアプリケーションによってはメモリやSSHの制限にて起動や計算実行が出来ないアプリケーションがございます。- メモリについては適切な資源タイプをご利用下さい

- Fluent SSH制限によって起動不可、回避策は -ncheck オプションを利用する(メーカーサポート外)

- Schrodinger SSH制限によって計算実行は不可(起動可)、回避策はf_node利用のみ

初めて接続したノードがある場合や、以前接続したことのあるホストの証明書が変更された場合に出力されるもので、known_hostというSSHサーバ証明書リストにIPアドレスXXX.XXX.XXX.XXXの証明書を追加したというメッセージです。これは正常な動作であり、計算結果には影響しないため無視して構いません。

qsubコマンドを実行した直後に発生するエラーメッセージとその対処法について説明します。

Unable to run job: Job is rejected because too few parameters are specified.

必須パラメーターが指定されていません。資源タイプと資源数、及び実行時間を指定する必要があります。

qsub: Unknown option

qsubのオプション指定に誤りがあります。こちらをご覧ください。

Unable to run job: Job is rejected. core must be between 1 and 2.

お試し実行ではジョブあたり3つ以上の資源数を使用することはできません。資源数は1または2を指定してください。

Unable to run job: Job is rejected, h_rt can not be longer than 10 mins with this group.

お試し実行では実行時間が10分を超えるジョブを投入することはできません。こちらをご覧ください。

Unable to run job: Job is rejected. You do Not enough point to finish this job.

指定した資源及び時間を確保するためのポイントが不足しています。TSUBAMEポータルページからポイント状況をご確認下さい。

Unable to run job: failed receiving gdi request response for mid=1 (got syncron message receive timeout error).

もしくはUnable to run job: got no response from JSV script"/apps/t3/sles12sp2/uge/customize/jsv.pl".短時間における大量のジョブ投入等によって管理ノードが高負荷な状態になると、ジョブスケジューラーとの通信がタイムアウトとなり上記のエラーメッセージが表示される事があります。高負荷な状態は一時的なものです。暫く時間を置いた後に再投入を試みてください。

高負荷な状態でのエラーはここに記載していないエラーや、その他の項目で記載されているエラーが発生する場合があります。

TSUBAME3ではバッチジョブスケジューラによる資源管理を行っております。

資源タイプ

利用可能な資源タイプは以下の6つがあります。

資源タイプの指定は「-l」オプションで行います。(「-pe」や「-q」オプションは利用できません。)資源タイプ名 使用物理CPUコア数 メモリ(GB) GPU数 F f_node 28 235 4 H h_node 14 120 2 Q q_node 7 60 1 C1 s_core 1 7.5 0 C4 q_core 4 30 0 G1 s_gpu 2 15 1

ジョブの投入方法ジョブはログインノードから以下のようなコマンドで投入できます。

・ジョブスクリプトによる投入(GSICGROUPに所属しているユーザがtrain.shを実行する場合)qsub -g GSICGROUP train.sh ・インタラクティブジョブを実行する場合(GSICGROUPに所属しているユーザが2時間s_coreをX環境下で利用する場合)

qrsh -g GSICGROUP -l s_core=1,h_rt=2:: -pty yes -display $DISPLAY -v TERM /bin/bash

ジョブスクリプトによる投入での資源タイプ指定方法などジョブの投入方法の詳細については利用手引きをご確認ください。

利用の手引き 5.2. ジョブの投入

また、ここで説明していない項目については下記の関連FAQをご確認ください。

関連FAQ

スクラッチ領域の利用方法

依存ジョブの投入方法について

qrshでX転送する方法ジョブの制限について

最新の制限については「各種制限値一覧」を確認してください。

ユーザごとの制限を超えるジョブはTSUBAME全体に空きがある場合でも実行されず、qw状態で待たされます。

ジョブが終了し、制限を下回ると(TSUBAMEに空きがある範囲で)実行状態rに遷移します。予約について

予約は1時間単位で設定可能で予約終了時刻の5分前までノードを利用することができます。

ジョブ投入時には以下のようなコマンドで実行する必要があります。AR IDはポータルで確認が可能です。$ qsub -g [TSUBAME3グループ] –ar [AR ID] スクリプト名 予約終了時刻の5分前までの利用となるため、ジョブスクリプトの-lオプションを工夫する必要があります。

例)予約期間が2日の場合の資源指定#$ -l h_rt=47:55:00 「ノード予約」には上記の「ジョブの制限」はかからず、「ノード予約」の制限があります。

制限については「各種制限値一覧」を確認してください。

関連FAQ

TSUBAME2.5とTSUBAME3.0の主な違いについて (ノード予約)エラーの対処

エラーの対処については下記の関連FAQをご確認ください。

関連FAQ

ジョブ投入時にエラーになりますが、どのオプションが悪いかわかりません

ジョブステータスが「Eqw」となり実行されない。

qrshコマンドを実行した際のエラーについて

結果ファイルのエラーメッセージについて

予約実行時にジョブが投入できない際のトラブルシューティングについてまとめています。

以下のコマンドはGSICグループが2日の利用となるAR番号20190108を実行する場合を例としております。1.ARIDのつけわすれ

arオプションをつけない場合は通常ジョブとして実行されます。

(ポイントも通常通り消費されます)NG例

以下のコマンドを実行した場合は、通常ジョブとして実行されます。$ qsub -g GSIC hoge.sh OK例

予約実行を行う際は必ず-arオプションを利用してください。$ qsub -g GSIC -ar 20190108 hoge.sh 2.h_rtが予約時間より長い

h_rtオプションの時間指定が予約時間より長い場合はジョブが流れません。

また、予約終了時刻の5分前までの利用となる仕様のため、指定時間は予約時間より5分短くしてください。NG例

予約時間いっぱいとなっているため、実行されません。$ grep h_rt hoge.sh

#$ -l h_rt=48:00:00

$ qsub -g GSIC -ar 20190108 hoge.shOK例(終了時刻-5分となっている)

$ grep h_rt hoge.sh

#$ -l h_rt=47:55:00

$ qsub -g GSIC -ar 20190108 hoge.sh

プログラムが異常終了した場合や予約開始時間前にジョブを投入できなかった場合など、予約開始時間後に実行する場合は経過時間を考慮する必要があります。

例えば、予約開始時間から2時間経過したあとにジョブを投入する場合は以下のようなスクリプトとなります。(qsubコマンド実行から計算ノードの割当までの内部処理の時間を1分取った場合)$ grep h_rt hoge.sh

#$ -l h_rt=45:54:00

$ qsub -g GSIC -ar 20190108 hoge.sh

関連URL

TSUBAME3.0利用の手引き 「5.3. 計算ノードの予約」

h_rtで指定した時間には利用者が投入したジョブを実行するための準備処理の時間も含まれます。 そのため、h_rtで指定した時間全てがジョブの実行時間にはなりません。 ポイント消費の対象は準備処理の時間を除いたジョブの実行時間となります。 また、準備処理の時間はジョブが実行されるノードの状況により、一定ではありません。

モジュールコマンドが初期化されていない場合などに本エラーが発生します。

moduleコマンドで発生している場合は、バッチスクリプト内のmodule load XXXX の行の前に

. /etc/profile.d/modules.sh を追加することでモジュールコマンドを手動で初期化することができます.実行シェルがsh, bashの場合でintelモジュールを読み込む場合

. /etc/profile.d/modules.sh

module load intel実行シェルがcsh, tcshの場合でintelモジュールを読み込む場合

source /etc/profile.d/modules.csh

module load intelpip等でインストールしたコマンドをジョブスクリプト・qrshから実行した場合に、"command not found"エラーが発生した場合はログインノードにて

$ type <command>

<command> is hasehd (/path/to/<command>)でパスを確認し、ジョブスクリプトに

export PATH=$PATH:/path/to のように、利用したいコマンドの存在するディレクトリを追記して下さい。

関連URL

以下のようにして、1つのジョブの中で複数のプログラムを別々のCPU/GPUで走らせることができます。

以下ではa.outがCPU0-6+GPU0, b.outがCPU7-13+GPU1, c.outがCPU14-20+GPU2, d.outがCPU21-27+GPU3を使います。

#!/bin/sh

#$ -cwd

#$ -V

#$ -l f_node=1

#$ -l h_rt=00:30:00a[0]=./a.out

a[1]=./b.out

a[2]=./c.out

a[3]=./d.out

for i in $(seq 0 3)

do

export CUDA_VISIBLE_DEVICES=$i

numactl -C $((i*7))-$((i*7+6)) ${a[$i]} &

done

wait

webサービス(jupyter lab)が起動できない場合、以下の点についてご確認下さい。

ログを読んで何が起こっているか調べる

~/.t3was/ 以下に、Webサービス関係のジョブの出力ファイル(エラーログ)が保存されています。

こちらのファイルの中にエラーの原因のヒントがあるかもしれません。環境を初期化してみる

~/.local/lib/python3.6/ を別ディレクトリに退避するなどして、

Python 3.6の環境を初期化することで、自分で$ python3 -m pip install --user (modulename) したモジュールとの競合が解決できるかと思います。

これで起動に成功した場合、Jupyter Lab内のコンソールから改めて

必要なモジュールをインストールし、その後$ python3 -m pip check で依存関係に問題が出たモジュールを

$ python3 -m pip install -U --user (modulename) で更新することで、問題が解決されるかと思います。

環境を初期化せずに、モジュールの依存関係を確認する

前項とほぼ同じですが、SSHでTSUBAMEにログイン後

$ module load jupyterlab/3.0.9 とすることで、WebサービスのJupyter Lab環境が読み込まれます。(3.0.9まで指定する必要があります)

その状態で、$ python3 -m pip check を実行し、依存関係に問題があるモジュールがないかご確認ください。

問題があるものがあれば、$ python3 -m pip install -U --user (modulename) で更新してください。

アプリケーション

以下のコマンドでユーザのホームディレクトリにインストールすることができます。(下記例はTheanoの場合)

実際には御自分で利用したいpython環境の各モジュールファイルを指定ください。$ module load python-extension/2.7

$ pip install --user theanoインストール後にジョブスクリプトから利用する場合は、コマンドの前に下記の2行を記述してください。

. /etc/profile.d/modules.sh

module load python-extension/2.7関連URL

python/3.6.5を用いて最新版のnumpy, mpi4py, chainer, tensorflow等をインストールする方法について

本項目のXアプリケーションはTSUBAME3上にインストールされている、X環境上で動作するアプリケーション、いわゆるGUIのアプリケーションのことを指します。基本的にはユーザ環境のため、窓口ではサポート出来かねます。

Xアプリケーションを利用したい場合には、下記の手順で動作環境のセットアップ・確認を行ってください。

1.Xサーバアプリケーションがクライアントにインストール、起動しているか

Windowsの場合

Windowsの場合は多くのXサーバアプリケーションがあります。

Xサーバアプリケーションがインストールされているか、または起動しているかをご確認ください。Macの場合

XQuartz がインストール、設定されているかをご確認ください

https://support.apple.com/ja-jp/HT201341Linuxの場合

X11サーバアプリケーションと関連ライブラリがインストール、設定されているかをご確認ください

2.X転送オプションを有効にしているかどうか

Windows(その他の端末アプリケーション)

ご利用の端末およびXサーバアプリケーションによって設定が異なります。

各アプリケーションのマニュアルを確認下さい。Linux/Mac/Windows(Cygwin)

SSHコマンドにX転送オプション(-YC)が入っているかをご確認ください。

$ ssh TSUBAME3アカウント名@login.t3.gsic.titech.ac.jp -i 秘密鍵 -YC例)アカウント名がgsic_user、秘密鍵が~/.ssh/t3-keyの場合

$ ssh gsic_user@login.t3.gsic.titech.ac.jp -i ~/.ssh/t3-key -YCSSHのオプションについては下記のコマンドで確認してください。

$ man ssh3.端末環境を変えても再現するか

Windowsの場合はフリー、有償を含め多くの端末/Xサーバアプリケーションがございます。

別の端末/Xサーバアプリケーションでも再現するかどうかをご確認ください。

(もちろん、組み合わせの問題もあります)

isvアプリケーションによって相性があり、再現しない場合はアプリケーション固有の問題である可能性がございます。

その場合はお問合わせ頂いてもご対応できかねますので、ご了承ください。GL対応/非対応によっても異なります。一例としてGL対応のXサーバには以下のものがございます。

- アールワークス社ASTEC-X

- マイクロフォーカス社Reflection

- PTC社PTC X/Server

また、利用したいXアプリケーションによってはコマンドオプションが必要な場合があります。

利用したいXアプリケーションのマニュアルをご確認下さい。通常のX転送/VNC接続では動作しないGLアプリケーションでもVirtualGLを使用することで動作する場合がございますので必要であればお試し下さい。

VirtualGLの詳細については利用の手引きをご確認下さい。

4.動作確認

ログインノードでは、以下のコマンドでX Window Systemの標準的なターミナルエミュレータが起動します。ログインノードまでのX転送の設定の確認にご利用ください。

$ xterm

xtermが動作するが、利用したいXアプリケーションが動作しない場合は3をお試しください。

問題がある場合の例xterm: Xt error: Can't open display:

xterm: DISPLAY is not set

上記のエラーが出る場合は、1,2をご確認下さい。5.アプリケーションの利用

ログインノードはCPUを占有するアプリケーションの利用を想定しておりません。可視化を含む本格的な利用には、計算ノードを利用してください。

計算ノードでのGUIアプリケーションの利用については、下記FAQをご参照ください。

FAQ: qrshでX転送する方法

また、f_nodeでノード全体を確保している場合は、ssh -Y コマンドでX転送を行うこともできます。

問い合わせ時に必要な情報

お問い合わせの際は下記をご連絡ください

■利用OS(例 Windows10,Debian10,macOS Sierra10.12.6)

■利用ソフトウェア(windowsのみ、例 Cygwin,PuTTY/VcXsrv,Rlogin/Xming)

■利用バージョン

windowsの場合は端末/Xサーバアプリケーションの両バージョン 例 2.9.0-3,0.70,2.22.7

バージョンの調べ方はアプリケーションのマニュアルをご確認ください。

Linux/Macの場合はSSHのバージョンをお送りください。下記のコマンドで確認できます。$ ssh -V■今まで試した内容について、また、エラーが出る場合はエラーの内容をお送りください。

以下の項目に当てはまるかをご確認下さい。

当てはまる場合、利用者の責任で自由にインストールしてご利用いただけます。

これらに問題が無いか導入したいアプリケーションのインストールマニュアルや利用許諾書をご確認ください。- TSUBAMEのOS(SUSE Linux Enterprise Server 12 SP5)上で動作する (WindowsやMac OS専用のソフトウェアは動作しません)

- インストールや実行に管理者権限(root)が不要

- 自分のホームディレクトリやグループディスクへのインストールが可能(特定のノードへのインストールは不可)

- ライセンス的に問題ない

- kernel、ライブラリおよびシステムレベルの設定変更を必要としない

- GSICのサポートが不要

上記にもありますが、GSICでご用意するアプリケーションではありませんので基本的にはサポートは致しません。

利用者側でTSUBAMEの問題かアプリケーションの問題かの切り分けを行い、アプリケーションに関する事はソフトウエアの提供元へお問い合わせください。ライブラリやドライバのバージョンはTSUBAMEの定期メンテナンス等で変更になることがあります。

その結果それまで利用していたアプリケーションの再設定が必要になる場合があります。

場合によっては動作しなくなってしまう可能性も無いとは言えませんのでご注意ください。

配布ソフトウェアに関して生じるトラブルのほとんどは環境に起因するため、個別のサポートは行いません。

申請にあたって承諾いただいたとおり「自己解決」して頂く必要がございます。インストール時に生じたトラブル

- インストールの手引きに従ってインストールをしてください。

- 上手くいかない場合はアンインストールして最初からやり直してください。

- ライセンスサーバとの通信に失敗している場合は研究室内や建物のネットワーク管理者に問い合わせてください。

利用中に生じたトラブル

- 実行できない場合はエラーメッセージ等をよく読んでください。

- ライセンス関連の問題が生じている場合はインストールの手引きにある通り、ライセンスサーバへの通信の問題がないか確認してください。

- 設定が正常にできており直前まで利用できていた場合はライセンスがメンテナンス中ではないかお知らせ等を確認してください。

- TSUBAMEの利用の手引きを参照してライセンスの状態を確認してライセンス数が不足していないか確認してください。他の人が使用中の場合は終わるのを待って再度実行してください。

1ユーザによるライセンスの占有が発生している場合にはお知らせください。利用方法を改めていただくようGSICより連絡させていただきます。

TSUBAME3上でISVアプリケーションの利用する場合は、下記の2つの場合があるかと思います。

それぞれの場合について簡単に説明します。- プリ・ソルバ・ポストの全処理を行う場合

- プリポスト処理はクライアント側で行い、ソルバ処理のみをTSUBAME3で実行する場合

本FAQにでてくる用語がわからない方は下部の用語についてをご確認下さい。1.プリ・ソルバ・ポストの全処理を行う場合

TSUBAME3ではアプリケーションによって異なりますが、基本的にプリ・ソルバ・ポストの全機能が導入されており、インタラクティブノードでの実行の場合は「プリ・ソルバ・ポスト」の全処理を行うことができます。

インタラクティブノードでの実行について、また、プリ、ポスト、ソルバに該当するコマンドやアプリケーションもisvアプリケーションによって異なりますので、各アプリケーションの手引書やマニュアルをご確認下さい。2.プリポスト処理はクライアント側で行い、ソルバ処理のみをTSUBAME3で実行する場合

Xサーバの相性問題などを回避する目的など、プリポスト処理をクライアント側で行えるよう、ソフトウェア配布を行っております。

なお、ソフトウェア配布については、利便性向上のために提供しているものですので、状況により配布を中止する可能性がありますのでご注意ください。この場合は、下記の手順が必要となります。

1) ソフトウェアの利用申請を行い、ソフトウェアを入手する

2) ソフトウェアをクライアントにインストールする

3) クライアントにインストールしたソフトウェアでプリ処理を行う

4) TSUBAME3に3.で作成したデータを転送する

5) ジョブスケジューラ投入用のバッチスクリプトを作成する

6) TSUBAME3でqsubコマンドを実行し、5で作成したバッチスクリプトを実行する

7) 6の結果データをクライアントに転送する

8) クライアントにインストールしたソフトウェアでポスト処理を行う2017/11/15段階ではTSUBAME2.5のソフトウェア配布サービスをご利用下さい。

TSUBAME3にて新規導入されたものについては配布ルールの策定中となっております。

(なお、配布されたアプリケーションについてはサポート範囲外となります)用語について

■プリポスト

下記の2つのこと、低負荷

プリ(プリプロセッサの略):解析用インプットファイルの作成などの計算前準備作業

ポスト(ポストプロセッサの略):解析結果データの可視化等の解析後の作業■ソルバ

解析そのもののこと、高負荷■Xサーバ

X転送を行うためのクライアント側のアプリケーション

全般

まず、以下の関連FAQをご確認ください。

Linuxのよくあるエラーについて

"Disk quota exceeded" というエラーが出力される

ISVアプリケーションで発生したエラーに対する対処方法について

1.isvアプリケーションの場合

ABAQUS/ABAQUS CAEを除き、お問合わせでサポート可能です。以下をお問い合わせにご連絡下さい。■エラーが発生したisvアプリケーション名

例)Abaqus/Explicit

■発生したエラー

例)buffer overflow detected

■エラーを起こしたJOB_ID(複数ある場合は複数記載してください)

例)181938

■エラーを起こしたホスト名(複数ある場合は複数記載してください)

例)r6i7n5

■エラーが発生した状況について(できるだけ詳細に記載下さい)

例)qrshを用いてr6i7n5にログインし、以下のコマンドを実行したところ、「buffer overflow detected」が発生した。

詳細は以下の通り

#コマンド$ module load abaqus intel-mpi

$ abq2017 interactive job=TEST input=Job1 cpus=6 scratch=$TMPDIR mp_mode=mpi

#エラー内容

Run package

*** buffer overflow detected ***:

/pathto/package terminated

======= Backtrace: =========

/lib64/libc.so.6(+0x721af)[0x2aaab0c001af]

…以下略ABAQUSについてはアカデミックライセンスのため、技術サポートがありません。

SIMULIAドキュメンテーションサイトに登録し、ご自分で解決頂く必要がございます。

ドキュメンテーションサイトの情報については「お問い合わせ」よりご連絡ください。

2.自分でコンパイルしたアプリケーションの場合

お問合わせ頂いてもサポートできません。

FAQ「TSUBAME3で提供していないアプリケーションを使用したい」をご確認したという前提で記載致します。トレースバックなどのオプションを付けてコンパイルしている場合はエラーを起こしたソースに関する情報が出ますので、そちらを確認して下さい。

オプション無しでコンパイルした場合はエラーを確認して、必要とされるオプションを切り分けて下さい。intelやpgiコンパイラを利用した場合はそれぞれの手引書をご確認下さい。

また、Allinea FORGEによるデバッグも可能です。

全般

- プログラム実行時に以下のようなエラーが発生する場合の対処法

unable to connect to forwarded X server: Network error: Connection refused Error: Can't open display: localhost:13.0アプリケーション名: Xt error: Can't open display: アプリケーション名: DISPLAY is not setXサーバの設定が不適切と思われます。FAQ「Xアプリケーション(GUI)が動作しません」の1,2を確認して下さい。

- プログラム実行中にGUIプログラムが落ちる

端末上のkeepAliveの設定はお済みでしょうか?

お済みでない場合はFAQ「TSUBAME3で作業中にセッションが切れてしまいます」を確認して下さい。

- プログラム実行中に突然ジョブがabortした

原因は様々考えられますが、ユーザによる切り分けとして以下を確認下さい。

・バッチエラーファイルの確認(通常、スクリプト名.e.$JOBID)

・プログラム固有のログファイルの確認

・ディレクトリの空き容量の確認

関連FAQ

Linuxのよくあるエラーについて

"Disk quota exceeded" というエラーが出力される

segmentation faultなど、プログラム実行時のエラー対応について

Maple

- プログラム実行時に以下のようなエラーが発生する場合の対処法

Exception in thread "Request id 1" java.lang.UnsupportedOperationException:PERPIXEL_TRANSLUCENT translucency is not supportedアプリケーションとXサーバの相性です。FAQ「Xアプリケーション(GUI)が動作しません」の3を確認して下さい。

X-mingなどで発生し、mobaXtermで発生しないことを確認しております。

ANSYS

全般

- プログラム操作時にGUIがフリーズする場合の対処法

アプリケーションとXサーバの相性です。FAQ「Xアプリケーション(GUI)が動作しません」の3を確認して下さい。

本現象はGL非対応のXサーバで発生しており、GL対応のASTEC-Xでは発生しておりません。

また、R18.2では、XmingのGL対応版(Xming-mesa) で動作を確認しております。

GL対応のXサーバをご利用下さい。Fluent

- プログラム実行時に以下のようなエラーが発生する場合の対処法

利用ノード/プロセス数をライセンス制限に合致する様に減らしてください。

下記の例ではHPCライセンスを94利用しようとしています(f_node3台)

なお、f_node2台の場合は制限内となるため、エラーは出ません。

参考:ANSYSのライセンス制限の適用について(1/31実施)Unable to spawn node: license not available. ANSYS LICENSE MANAGER ERROR:The request for 94 tasks of feature aa_r_hpc cannot be granted. Only 16 tasks are available. Request name aa_r_hpc does not exist in the licensing pool. Checkout request denied as it exceeds the MAX limit specified in the options file. Feature: aa_r_hpc License path: 27001@lice0:27001@remote:27001@t3ldap1: FlexNet Licensing error:-194,147 For further information, refer to the FlexNet Licensing documentation, available at "www.flexerasoftware.com". Hit return to exit. The fluent process could not be started.

ABAQUS

- プログラム実行時に以下のようなエラーが発生する場合の対処法

Error in job ***: Error checking out Abaqus license.

loginノードで実行した場合は正常な処理です。ログインノードではソルバーライセンスは利用できません。

参考:loginノード上でのABAQUS解析の禁止とメンテナンスによるサービス停止について(10/23実施)

対応策としては、バッチジョブスケジューラをご利用下さい。

TSUBAME3.0利用の手引きのジョブスケジューリングシステムをご確認下さい。- プログラム実行時に以下のようなメッセージが発生しジョブが動かない場合の対処法

Analysis initiated from SIMULIA established products Abaqus JOB intel_int Abaqus 3DEXPERIENCE R2017x Successfully checked out QEX/103 from DSLS server remote Queued for QXT/103 "QXT" license request queued for the License Server on remote. Total time in queue: 60 seconds. Position in the queue: 1 Total time in queue: 30 seconds. Position in the queue: 2 Total time in queue: 91 seconds.ライセンスが不足しているため、他の計算が終了するのを待っています。

ライセンスがあくまでお待ち下さい。

このダイアログが表示されている状態では計算ノードのポイント消費については行われます。- Abaqus/Explicitで並列実行時に以下のようなエラーが発生する

Abaqus Error: Abaqus/Explicit Packager exited with an error - Please see the status file for possible error messages if the file exists. Begin MFS->SFS and SIM cleanup Fri 17 Aug 2018 10:40:23 AM JST Run SMASimUtility Fri 17 Aug 2018 10:40:24 AM JST End MFS->SFS and SIM cleanup Abaqus/Analysis exited with errors

回避策として、以下の様に対策用モジュールを読み込んでください

abaqus/2017読み込んでいる場合はmodule purgeコマンドを実行してから以下を実行してください。$ module load abaqus/2017_explicit

COMSOL Multiphysics

- プログラム実行時に以下のようなエラーが発生する場合の対処法

GL非対応のXサーバで発生します。GL対応のXサーバを利用するかsoftwer renderingモードで実行下さい。

$

comsol -3drend swfunction is no-op

#

# A fatal error has been detected by the Java Runtime Environment:

#

# SIGSEGV (0xb) at pc=0x00007fff0f0252bf, pid=10485,

tid=0x00007fff0e7f9700

#

# JRE version: Java(TM) SE Runtime Environment (8.0_112-b15)

(build1.8.0_112-b15)

# Java VM: Java HotSpot(TM) 64-Bit Server VM (25.112-b15 mixed

modelinux-amd64 compressed oops)

# Problematic frame:

# C [libcs3d_ogl.so+0x2a2bf]

#

# Failed to write core dump. Core dumps have been disabled. To enable

coredumping, try "ulimit -c unlimited" before starting Java again

#

# An error report file with more information is saved as:

# /home/XX/XXXXXX/hs_err_pidXXXXXX.log

#

# If you would like to submit a bug report, please visit:

# http://bugreport.java.com/bugreport/crash.jsp

#

/apps/t3/sles12sp2/isv/comsol/comsol53/multiphysics/bin/comsol: line

1615:10485 Aborted (core dumped)

${MPICMD}${FLROOT}/bin/${ARCH}/comsollauncher --launcher.ini

${LAUNCHERINIFILE}${LAUNCHERARGS} ${MPILAUNCHERARGS}- プログラム実行時に以下のようなエラーが発生する場合の対処法

ライセンス不足のエラーです。ライセンスがあくまで待って再実行して下さい。

ライセンスの確認については手引書を確認して下さい。/******************/

/*****Error********/

/******************/

Could not obtain license for COMSOL Multiphysics. License error: -4.

Licensed number of users already reached.

Feature: COMSOL License path:

/apps/t3/sles12sp2/isv/comsol/comsol53/multiphysics/license/license.dat:

FlexNet Licensing error:-4,132 For further information,

refer to the FlexNet Licensing documentation,

available at "www.flexerasoftware.com".

Total time: 4 s.

Materials Studio

- プログラム実行時に以下のようなエラーが発生する場合の対処法

下記のエラーだけでは複数の原因が考えられますので必ずアウトプットファイルを確認してください。

ライセンスエラーの場合The job has failed. Download any results generated so far? (Results files will be permanently removed from Server)

以下の例のような場合はライセンスエラーです。ライセンスがあくまで待って再実行して下さい。

研究室などTSUBAME以外での実行では必ず発生しますが2018年夏季メンテナンス以降では正常な処理です。

参考:ISVアプリケーション利用に関するライセンス制限について

対応策としては、バッチジョブスケジューラをご利用下さい。

TSUBAME3.0利用の手引きのジョブスケジューリングシステムをご確認下さい。

アウトプットファイル(CASTEPの例)Job started on host GSIC at Thu Aug 16 13:20:06 2018 +-------------------------------------------------+ | | | CCC AA SSS TTTTT EEEEE PPPP | | C A A S T E P P | | C AAAA SS T EEE PPPP | | C A A S T E P | | CCC A A SSS T EEEEE P | | | +-------------------------------------------------+ This version was compiled for x86_64-windows-msvc2013 on Dec 07 2016 Code version: 7217 Intel(R) Math Kernel Library Version 11.3.1 Fundamental constants values: CODATA 2010 ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~略~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~ Licensing Error ! Error: Manual heartbeat setup for MS_castep license failed Failed to check out licenses Trace stack not available

アウトプットファイル(Dmol3の例)

=============================================================== Materials Studio DMol^3 version 2017 R2 compiled on Dec 7 2016 22:56:21 =============================================================== ~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~略~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~ DATE: Aug 16 13:20:06 2018 Job started on host GSIC This run uses 1 processors Licensing Error ! Error: Failed to checkout MS_dmol license Message: DMol3 job failed Error: DMol3 exiting Message: License checkin of MS_dmol successful

ARM

- ライセンスエラーの場合

以下の例のような場合はライセンスエラーです。ライセンスがあくまで待って再実行して下さい。

MAP: Your licence does not currently have enough processes available.

MAP: Requested Processes: 4

MAP: Available Processes: 3

Arm Forge 19.0.5 - Arm MAP

MAP: Your licence does not currently have enough processes available.

MAP: Requested Processes: 4

MAP: Available Processes: 2

MAP: Unable to obtain a valid licence.

Unable to obtain a valid licence.

Waiting for seat

まず、以下をご確認下さい。

FAQ「TSUBAME3で提供していないアプリケーションを使用したい」

1.インストール場所について

インストール場所としては下記の2箇所がございます。

インストールされるソフトウェアの運用形態に合わせて選択して下さい。

研究室のメンバーなど、TSUBAMEグループ内で共有する必要がある場合は高速ストレージ領域をご利用下さい。

*Homeディレクトリはchmod等で権限を変更したとしても共有利用はできません。・Homeディレクトリ(/home/[0-9]/ユーザアカウント/)

・高速ストレージ領域、いわゆるグループディスク(/gs/hs[0-1]/TSUBAMEグループ)2.インストール方法

インストールされるアプリケーションのマニュアル、コミュニティ、READMEを確認し、インストールして下さい。

アプリケーションによっては、ライブラリ等の動作環境含め、御自分でソースからコンパイルする必要がございます。

*ユーザインストールとなるため、zypper等のOS基幹のアプリケーション管理ソフトウェアは利用できず、基本的にソースからのコンパイルとなります。

また、CUDAを利用する場合は計算ノードでのコンパイルが必要となります。(ログインノードにはGPUが搭載されていないため)例1)configureスクリプトを実行し、Makefileを生成してからmake,make testおよびmake installする例

$ ./configure --prefix=$HOME/install

$ make && make test

$ make install例2)ビルド用ディレクトリを生成し、cmakeを行い、make installする例

$ mkdir build && cd build

$ cmake .. -DCMAKE_INSTALL_PREFIX=$HOME/install

$ make install例3)インストールスクリプトでインストールする例

$ ./install.sh

3.pythonモジュールのインストール方法

pythonモジュールのインストールについては下記の関連URLをご確認ください。関連URL

python/3.6.5を用いて最新版のnumpy, mpi4py, chainer, tensorflow等をインストールする方法について

python/3.6.5を用いて最新版のnumpy, mpi4py, chainer, tensorflow, cupy等をインストールする方法について

python/3.6.5を使って自分の環境下にnumpy, mpi4py, chainer, tensorflow等をインストールしたい場合は以下のようにします。

$ module purge

$ module load python/3.6.5

$ module load intel cuda openmpi

$ python3 -m pip install --user python_modulesバージョンを指定したい場合は

$ python3 -m pip install --user python_modules==version

※cupy等GPUを用いるモジュールをインストールする場合は、qrshで計算ノードを確保してから行って下さい。

※CuPyは、pip install時にCUDAバージョンに合った cupy-cuda102 などのモジュールを指定することで、高速にインストールを行うことができます。

intel MKLをリンクしたnumpyのインストール方法について

https://github.com/numpy/numpy/blob/master/site.cfg.example を~/.numpy-site.cfgにコピーし、[mkl]の項目を以下のように編集します。

[mkl]

library_dirs = /apps/t3/sles12sp2/isv/intel/compilers_and_libraries_2018.1.163/linux/mkl/lib/intel64

include_dirs = /apps/t3/sles12sp2/isv/intel/compilers_and_libraries_2018.1.163/linux/mkl/include

mkl_libs = mkl_rtその後、以下を実行します。

$ module load intel python/3.6.5

$ python3 -m pip install --no-binary :all: --user numpy

アプリケーションの学内利用に際し、以下の利用制限がございます。

(同時実行数に上限がないアプリケーションのGaussian、AMBERは除く)ライセンス数が少ないアプリケーションについては占有せずにご利用願います。

研究室などでの利用で、起動したままでもライセンスは消費されますので、

アプリケーション利用終了後には必ずアプリケーションを停止するようにお願いいたします。ライセンスの長期利用が判明した場合は無警告、強制的にライセンスを回収するため、アプリケーションの動作が不安定となります。場合によっては接続を遮断することがあります。

(研究室端末のみ)全般

最長連続利用期間:1週間

制限は一人あたりの使用量(Materials Studioを除く)ABAQUS

実行場所 制限 TSUBAME計算ノード ソルバーは14Token制限 TSUBAMEログインノード CAE/CAXベースライセンス以外の実行制限あり 研究室端末 ログインノードと同様 ANSYS

実行場所 制限 TSUBAME計算ノード ベースライセンスは4Token制限

HPCライセンスは64Token制限TSUBAMEログインノード ベースライセンスは4Token制限

HPCライセンスの実行不可研究室端末 ログインノードと同様 Materials Studio

実行場所 制限 TSUBAME計算ノード CASTEP、DMol3の同時利用数20Token制限(*全ユーザでの総数)

ユーザあたり同時利用数6Tokenの制限TSUBAMEログインノード 使用禁止 研究室端末 CASTEP及びDMol3の使用を制限

COMPASSの同時利用数4Token制限

visualizerの同時実行を制限

ユーザあたり同時利用数6Tokenの制限(DiscoveryStudioとの合計)Discovery Studio

実行場所 制限 TSUBAME計算ノード 使用不可 TSUBAMEログインノード 使用禁止 研究室端末 CHARMM及びCHARMM Liteの同時利用数20Token制限

visualizerの同時実行を制限

ユーザあたり同時利用数6Tokenの制限(MaterialsStudioとの合計)

関連URL

2018年度の繁忙期ライセンス追加の廃止について

loginノード上でのABAQUS解析の禁止とメンテナンスによるサービス停止について(10/23実施)

既知の問題として、OpenMPIでGPUバッファを対象とした集団通信実行時にデータが化ける現象がございます。

(2019.04) この問題は2018年度末メンテナンスのアップデートで解消されています。この問題に遭遇した場合、回避策として以下をお試し下さい。

- MPI_Allgather()

mpirun -mca coll_tuned_use_dynamic_rules 1 -mca coll_tuned_allgather_algorithm 2

- MPI_Alltoall()

mpirun -mca coll_tuned_use_dynamic_rules 1 -mca coll_tuned_alltoall_algorithm 3

もし上記で解決しなかった場合、以下をお試し下さい。

mpirun -mca pml ob1

この問題はOPA10.8(2018年度末メンテナンスでアップデート予定)で修正される予定です。

TSUBAME3 ではR-3.4.1が利用できます。

基本パッケージ以外に標準で利用可能なライブラリは以下となります。

Rmpi, rpud, rpudplusその他の利用可能なライブラリはlibrary()コマンドでご確認ください。

上記以外のライブラリを利用したい場合には、ご自分でのインストール操作が必要となります。

パーミッションの関係で、Rのインストールディレクトリは不可ですので、ライブラリパスを指定の上、

自分所有のライブラリをインストール/管理できますます。手順は以下となります。

ライブラリパスを$HOME/Rlib、ライブラリ名はtestlib、testlib.tar.gzはソースパッケージと

仮定して、以下のように操作します。モジュールの読み込み:

$ module load cuda openmpi rライブラリインストールディレクトリの作成(無ければ):

$ mkdir ~/Rlibパッケージのダウンロード:

$ wget https://cran.r-project.org/src/contrib/testlib.tar.gzライブラリインストール:

$ R CMD INSTALL -l $HOME/Rlib testlib.tar.gzご自分のインストールライブラリの設定:

$ export R_LIBS_USER=$HOME/Rlibライブラリの利用:

$ R

> library(testlib)

openmpiを用いたmpi4pyでmpi4py.futures.MPIPoolExecutorを実行すると以下のようなエラーが起こることがあります。

[r5i7n2:26205] [[60041,0],0] ORTE_ERROR_LOG: Not found in file orted/pmix/pmix_server_dyn.c at line 87 上記のエラーに遭遇した場合、以下のいずれかをお試し下さい。

1. mpirun -np <NP> python3 -m mpi4py.futures ./test.py

2. intel MPIを用いたmpi4pyを使用する

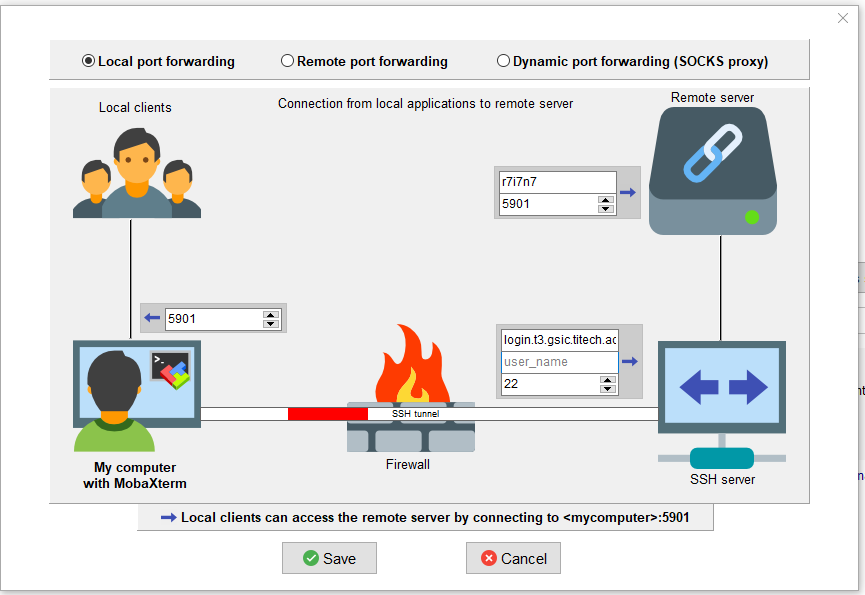

各ターミナルソフトでのポートフォワードの設定について以下に記します。

※以下は全てqrshやqsubで計算ノードを確保した状態で実行して下さい。

例として、計算ノードr7i7n7が確保されていると仮定して、自分のPCのポート5901をr7i7n7のポート5901に繋げる場合を記します。

1. MobaXterm

Tunneling -> New SSH Tunnel -> My computer with MobaXtermのForwarded portに5901を入力、SSH serverのSSH serverにlogin.t3.gsic.titech.ac.jp、defaultuserにユーザ名、SSH portに22を入力、Remote serverのRemote serverにr7i7n7、Remote portに5901を入力しsave、Settingsの下の鍵マークから秘密鍵を選択、その後設定したトンネルをstart

2. OpenSSH/WSL

$ ssh -L 5901:r7i7n7:5901 -i <秘密鍵> -f -N <ユーザ名>@login.t3.gsic.titech.ac.jp

3. PuTTY

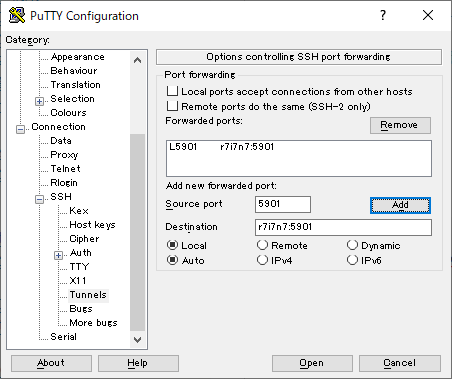

PuTTY Configuration -> Connection -> SSH -> TunnelsからSource Portに5901, Destinationにr7i7n7:5901を入力して"Add"をクリックしてOpen

4. teraterm

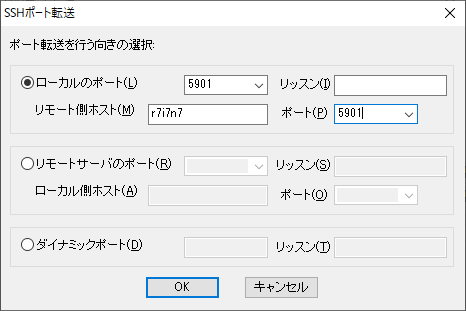

設定->SSH転送->追加->ローカルのポートに5901、リモート側ホストにr7i7n7、ポートに5901を入力してOK

intel MPIで

mpirun ... ./a.out >& log.txt &

としてバックグラウンド実行すると、log.txtへの出力が止まってしまうことがあります。

その場合は以下のようにすると出力が止まらずに実行できます。

mpirun ... ./a.out < /dev/null >& log.txt &

intel MKL ScaLAPCKをリンクしたい場合、https://www.intel.com/content/www/us/en/developer/tools/oneapi/onemkl-link-line-advisor.htmlに適切な項目を入力し、"Use this link line”からリンクオプションをコピーして下さい。

例:LP64でdynamic linkでintel MPI + ScaLAPACKをリンクする場合

-L${MKLROOT}/lib/intel64 -lmkl_scalapack_lp64 -lmkl_intel_lp64 -lmkl_intel_thread -lmkl_core -lmkl_blacs_intelmpi_lp64 -liomp5 -lpthread -lm -ldl

また、独自でインストールしたMPIでBLACSを使いたい場合は、

$ module load intel

した後に

$ cp -pr $MKLROOT/interfaces/mklmpi .

$ cd mklmpi

$ make libintel64 INSTALL_DIR=.

とするとcustom blacsライブラリが作成できますのでこちらを-lmkl_blacs_intelmpi_lp64と差し替えてご使用下さい。

intel-mpi/19.6.166またはintel-mpi/19.7.217をh_node, q_node等の共有資源タイプで実行すると以下のようなsegmentation faultが発生することがあることが分かっております。

$ mpirun -np 1 hostname

/apps/t3/sles12sp2/isv/intel/compilers_and_libraries_2020.0.166/linux/mpi/intel64/bin/mpirun: line 103: 24862 Segmentation fault mpiexec.hydra -machinefile $machinefile "$@" 0<&0本問題を回避するには、f_nodeを用いるかintel-mpi/19.0.117をご利用下さい。

qrsh後にsingularity buildを実行すると以下のようなエラーが発生することがあります。

INFO: Starting build...

FATAL: While performing build: conveyor failed to get: error getting username and password: error reading JSON file"/run/user/0/containers/auth.json": open /run/user/0/containers/auth.json:permission denied回避策として、qrsh後に

unset XDG_RUNTIME_DIR

を実行してからsingularity buildを実行して下さい。

2020/12/03 追記

ジョブスケジューラの設定でunset XDG_RUNTIME_DIRが行われるようになり、現在は上記は不要となっております。

TSUBAME上のGUIアプリケーションを利用する際に、X転送で描画に失敗する場合や、性能が不十分な場合には、TurboVNCを利用することで状況が改善する場合があります。

MobaxtermにはVNCクライアント機能が内蔵されているため、比較的簡単に利用できます。

計算ノードにおけるVNCサーバの起動方法やMobaxtermからの接続方法については、利用の手引きを参照してください。

TSUBAME上でRのV8、rstanをインストールするには以下のようにして下さい。

※確認したバージョンはV8: 3.4.2、rstan:2.19.3です。

それぞれ依存パッケージが多数ありますが、それらは問題なくインストールできるかと思いますのでダウンロードしてR CMD INSTALLLで依存パッケージをインストールしてから行って下さい。

* V8

$ module load gcc cuda openmpi r v8

$ R CMD INSTALL -l ~/Rlib /path/to/V8_3.4.2.tar.gz

* rstan

$ module load gcc cuda openmpi r

$ mkdir ~/.R/

$ vi ~/.R/Makevars <---- 以下を記入

CXX14FLAGS=-O3 -Wno-unused-variable -Wno-unused-function

CXX14 = g++ -std=c++1y -fPIC$ R CMD INSTALL -l ~/Rlib rstan_2.19.3.tar.gz

C++17 parallel algorithmsを使うためにはgcc/10.2.0等新しいバージョンのgccモジュールをロードする必要がございます。

nvhpcモジュールとgcc/10.2.0等を組み合わせてnvc++ -stdpar=gpu等でソースをコンパイルすると以下のようなエラーが発生することがあります。

"/apps/t3/sles12sp2/isv/nvidia/hpc_sdk/Linux_x86_64/21.7/compilers/include-stdpar/thrust/mr/new.h", line 44: error: namespace "std" has no member "align_val_t"

return ::operator new(bytes, std::align_val_t(alignment));

^"/apps/t3/sles12sp2/isv/nvidia/hpc_sdk/Linux_x86_64/21.7/compilers/include-stdpar/thrust/mr/new.h", line 66: error: namespace "std" has no member "align_val_t"

::operator delete(p, bytes, std::align_val_t(alignment));このエラーが発生する場合は以下をお試し下さい。

$ makelocalrc -x -d . -gcc `which gcc` -gpp `which g++`

$ export NVLOCALRC=$PWD/localrc

macOS Safari と jupyter lab の組み合わせで起きる既知のバグのようです。

https://xchop.blogspot.com/2019/03/macos-jupyter-labterminal.html

https://qiita.com/qasa/items/b5a6dce179efbf8760dc

別のブラウザ(chrome や firefox)をお使いください。

ABAQUS CAEのモデリングで「X fatal error. ***ABAQUS/ABQcaeG rank 0 terminated by signal 6 」というエラーが発生することがあります。

これはMobaXterm等でX転送でABAQUS CAEを起動してモデリングを実行すると発生するようです。

VNC+VirtualGLを使用することでこのエラーは回避できますのでそちらをご使用下さい。

MobaXtermからのVNCの使い方についてはこちらをご参照下さい。

ポータルからnoVNC経由でVNCを使う場合はこちらをご参照下さい。

VNCからVirtualGLを使用するにはこちらをご参照下さい。

Script Error: Microsoft JScript runtime error; Index out of bounds;

というエラーが表示され、ANSYS DesignModeler またはANSYS Mechanical が起動しない場合、以下をお試し下さい。

1. Ansys 関連のプログラムを全て終了します。

2. 該当の Linux マシンに該当の一般ユーザでログインして下記コマンドを実行してください。$ mv ~/.ansys ~/.ansys.bak

$ mv ~/.config/Ansys ~/.config/Ansys.bak

$ mv ~/.mw ~/.mw.bak

$ mv ~/.mw.old ~/.mw.old.bakFluentの場合

$ mv ~/.fluentconf ~/.fluentconf.bakCFXの場合

$ mv ~/.cfx ~/.cfx.bak

3. Ansys を再起動します (再起動すると、手順 2. の各フォルダに「.ansys」フォルダや「Ansys」フォルダが新しく生成され、個人設定がリセットされます)。

Tips (便利な設定など)

- openmpi 大規模集団通信の高速化

TSUBAME3のOPAは1ノードに4つついておりますが、デフォルトでは2つしか使用されません。

以下のように明示的に4つ使うようにすることで、大規模なノード数の際のMPI_Alltoall()のような通信量の多い集団通信が高速化する場合があります。

特にGPU通信時に効果的です。

- wrap.sh

#!/bin/sh

export NUM_HFIS_PER_NODE=4

if [ $((OMPI_COMM_WORLD_LOCAL_RANK%NUM_HFIS_PER_NODE)) == 0 ];then

export HFI_UNIT=0

elif [ $((OMPI_COMM_WORLD_LOCAL_RANK%NUM_HFIS_PER_NODE)) == 1 ];then

export HFI_UNIT=1

elif [ $((OMPI_COMM_WORLD_LOCAL_RANK%NUM_HFIS_PER_NODE)) == 2 ];then

export HFI_UNIT=2

elif [ $((OMPI_COMM_WORLD_LOCAL_RANK%NUM_HFIS_PER_NODE)) == 3 ];then

export HFI_UNIT=3

fi$*

- ジョブスクリプト例(f_node=8、GPUDirectあり)

#!/bin/sh

#$ -cwd

#$ -V

#$ -l h_rt=01:00:00

#$ -l f_node=8. /etc/profile.d/modules.sh

module purge

module load cuda openmpi/3.1.4-opa10.10-t3mpirun -x PATH -x LD_LIBRARY_PATH -x PSM2_CUDA=1 -x PSM2_GPUDIRECT=1 -npernode 4 -np $((4*8)) ./wrap.sh ./a.out

- openmpi p2p通信の高速化

複数のhfi(opa)をmultirail(束ねて使用)することによって、p2p通信が高速化される場合があります。

これはGPU通信ではあまり効果的ではないようですが、CPU通信では効果的のようです。

multirailを有効にするには以下のようにします。(openmpiの場合)

mpirun ... -x PSM2_MULTIRAIL=2 ... ./a.out また、multirail使用時のp2p通信のパフォーマンスはPSM2_MQ_RNDV_HFI_WINDOW(デフォルト値:131072、最大値:4MB)の値に依存するようです。

各パラメータの詳細な説明はこちらをご参照下さい。

- 1ノード内GPU通信について

TSUBAME3では1ノード内に4つのP100がついておりそれぞれNVLinkで接続されておりますが、ハードウェア構成の図にあります通りGPU0<->GPU2とGPU1<->GPU3間はNVLinkが2本で接続されており帯域幅が倍になっております。

可能であるならばこれらのGPU間で通信させるようにするとプログラムが高速化されるかもしれません。

※h_nodeではGPU0,1またはGPU2,3のみ確保されますので、これはf_nodeでしかできません。

- openmpi関連のtips

* 出力にランク番号を表示させたい場合

mpirun -tag-output ... * 集団通信のアルゴリズムを明示的に指定したい場合(デフォルトではMPIが動的にコミュニケータサイズ・メッセージサイズからアルゴリズムが選択されます)

例、MPI_Allreduce()の場合mpirun -mca coll_tuned_use_dynamic_rules 1 -mca coll_tuned_allreduce_algorithm <algo #> ... アルゴリズムの番号はAllreduceの場合、1 basic linear, 2 nonoverlapping (tuned reduce + tuned bcast), 3 recursive doubling, 4 ring, 5 segmented ring

詳細はompi_info --param coll tuned --level 9 または

ompi_info -all で確認できます。

また、

mpirun -mca coll ^tuned とすると集団通信のtunedモジュールをdisableにしてbasicモジュールに切り替えることができます。

パフォーマンス的には下がりますが、tunedモジュールに問題が疑われる場合は有効です。

* mpirunからlaunchされるプロセスをqrsh -inherit ...経由でなくssh経由にする(f_nodeのみ)

mpirun -mca plm_rsh_disable_qrsh true -mca plm_rsh_agent ssh ... デフォルトだとqrsh -inherit経由でプロセスがlaunchされますが、それに起因する問題がある場合はこちらをお試し下さい。

* 現在の設定MCAパラメータ一覧を表示

mpirun -mca mpi_show_mca_params 1 ... また、MCAパラメータは以下のように環境変数を用いて渡すこともできます。

export OMPI_MCA_param_name=value nameが変数名、valueが値になります。

* openmpiを使用しているジョブでsegmentation faultが発生した際にコアファイルを取得

openmpiでsegmentation fault等でコアを取得したい場合、ジョブスクリプト内部でulimit -c unlimitedとしても取得されないようです。

以下のようにラップするようにするとコアファイルが取得できますので、コアファイルが必要な場合にはお試し下さい。- ulimit.sh

#!/bin/sh

ulimit -c unlimited

$*mpirun ... ./ulimit.sh ./a.out * CPU binding関連

openmpiでのCPU binding関連のオプションは以下になります。

mpirun -bind-to <core, socket, numa, board, etc> ...

mpirun -map-by <foo> ...詳細はman mpirunをご参照下さい。

実際のbindingを確認したい場合は以下です。

mpirun -report-bindings ... - その他のtips

* GPUDirectのsend側の閾値

GPUDirectのsend側の閾値はデフォルトでは30000bytesとなっております.

recv側はUINT_MAX(2^32-1)なので、バッファサイズが大きい時にもsend側でもGPUDirectを常にONにしたければ以下のようにして下さい。mpirun -x PSM2_GPUDIRECT_SEND_THRESH=$((2**32-1)) ... 詳細はこちらをご参照下さい。

- NCCL使用時にジョブがハングする、またはエラーが発生する

NCCL使用時にジョブがハングする、またはエラーが発生するといった問題がいくつか報告されております。

カーネルパニックが発生する例も報告されております。

この問題にヒットしていると疑われる場合、以下をお試し下さい。

export NCCL_IB_DISABLE=1

または

export NCCL_BUFFSIZE=1048576

NCCL_IB_DISABLE=1はパフォーマンス低下する場合がございますので、その場合はNCCL_BUFFSIZE=1048576をお試し下さい。

- MPI+OpenACCを実行時にsegmentation faultが発生する

openmpi+OpenACCを使用時にsegmentation faultが発生する問題が報告されております。

回避策として、以下をお試し下さい。

export PSM2_MEMORY=large

または

export OMPI_MCA_pml=ob1

- GPUDirect使用時にエラーが発生する

(2021/08/19 追記)

本問題は今回のメンテナンスにより修正されております。

GPUDirect使用時にプログラム正常終了・異常終了時にまれにエラーが発生する事例が報告されております。

こちらもカーネルパニックを発生させる場合があるようです。

こちらが疑われた場合は、以下のようにしてGPUDirectをオフにしてお試し下さい。

mpirun ... -x PSM2_CUDA=1 -x PSM2_GPUDIRECT=0 - 大規模なジョブ時にmpirunがハングする

過去に大規模なジョブ時にmpirunがハングする事例が報告されております。

こちらはmpirunからfork()されるqrsh -inheritに起因するようです。

こちらが疑われた場合は、以下をお試し下さい。

* openmpiの場合

mpirun -mca plm_rsh_disable_qrsh true -mca plm_rsh_agent ssh ... * intel MPIの場合

export I_MPI_HYDRA_BOOTSTRAP=ssh

unset I_MPI_HYDRA_BOOTSTRAP_EXEC_EXTRA_ARGS※これらはf_nodeでのみ動作しますのでご注意下さい。

TSUBAME2.5からの移行

TSUBAME3.0とTSUBAME2.5では、コンパイラ、MPI、各種ライブラリが異なるため、そのまま動かすことができません。プログラムをTSUBAME3.0上でコンパイルし直す必要があります。

TSUBAME3.0に接続されているストレージはTSUBAME2.5のものと異なるため、TSUBAME2.5の/home, /work0, /work1, /data0 などに保存されたデータには直接アクセスることができません。

TSUBAME3.0へのデータ移行手順につきましては、準備ができ次第公開いたします。

TSUBAME2.5とTSUBAME3.0との主な違いについて説明します。それぞれの項目の詳細はTSUBAME3.0およびTSUBAMEポータルの利用の手引きをご参照ください。

定額利用オプションが廃止されました

TSUBAME2.5では、「定額利用(学内のみ)」と「従量利用(TSUBAMEポイントの購入)」の2通りの使い方がありました。

TSUBAME3.0では、定額利用が廃止され、学内・学外ともに従量利用に一本化されました。

支払い方法が前払いに一本化されました

TSUBAME2.5の従量利用では、「前払い」と「自動課金(学内のみ)」の2通りの支払い方法が用意されていました。

TSUBAME3.0では、自動課金が廃止され、学内・学外ともに前払いに一本化されました。

前払いで一度購入したポイントの払い戻しは原則行いませんので、購入の際にはグループ・支払コード・購入口数(価額)を確認のうえ、間違いのないように注意してください。学内からのパスワードによる計算機・ポータルへのログインが原則できなくなりました

TSUBAME2.5までは、学内からの計算機へのログインの際には、パスワード認証を用いることができました。

TSUBAME3.0では、セキュリティ向上のため、学内からのログインについても一部端末を除いてパスワード認証を行うことはできず、SSH公開鍵の登録が必要となります。

また、TSUBAMEポータルへのログインも東工大ポータルからのシングルサインオンおよびメールによるログイン用一時URLによって行う必要があり、いずれの方法でもパスワードは利用しません。

TSUBAME3.0でパスワードを利用する操作は以下の通りです。以下の機能を利用しない場合、パスワードを設定する必要はありません。

- CIFSによるTSUBAME3高速ストレージへの接続

- chshコマンドによるログインシェルの変更

- 教育用計算機システムへのログイン

- 一部演習室の端末・TSUBAME2(データ移行用)からのSSH鍵認証を利用しないログイン

- 一部ISVアプリケーションのライセンス利用

また、TSUBAME2.5ではパスワードに約半年の有効期限が設定されていましたが、TSUBAME3.0ではシステム上の有効期限は設定しておりません。パスワードの管理には十分な注意を払い、必要に応じて変更してください。

TSUBAMEポイント1ポイントの価格および価値が変わりました

TSUBAME2.5とTSUBAME3.0ではノードあたりの性能が異なるため、計算時間当たりの利用料が異なります。

また、TSUBAME2.5では1ポイントで約1ノード時(例: 1ポイントで2ノード30分の計算)ができましたが、TSUBAME3.0では1ポイントで約1ノード秒の計算(例: 3600ポイントで2ノード30分の計算)が行えます。詳細は、規則・利用細則のページより、最新の利用料に関する規則をご参照ください。

グループへのメンバー追加・他の教職員の予算利用などにおける本人確認が必要になります

TSUBAME3.0では、グループへのメンバー追加や、他の教職員が予算責任者となっている予算に関する支払コード作成時などに、当該の利用者の承認が必要になりました。